spark集群搭建(三台虚拟机)——hadoop集群搭建(2)

!!!该系列使用三台虚拟机搭建一个完整的spark集群,集群环境如下:

virtualBox5.2、Ubuntu14.04、securecrt7.3.6_x64英文版(连接虚拟机)

jdk1.7.0、hadoop2.6.5、zookeeper3.4.5、Scala2.12.6、kafka_2.9.2-0.8.1、park1.3.1-bin-hadoop2.6

前面搭建了spark集群需要的系统环境,本文在前文基础上搭建hadoop集群

一、配置几个配置文件

hadoop的下载和配置只需在spark1上操作,然后拷贝到另外两台机器上即可,下面的配置均在spark1上进行

$ cd /usr/local/bigdata/hadoop #进入hadoop安装目录

$ cd ./etc/hadoop

1、core-site.xml

$ vim core-site.xml

添加如下,指定namenode的地址:

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://spark1:9000</value>

</property>

</configuration>

2、hdfs-site.xml

$ vim hdfs-site.xml

<configuration>

<property>

<name>dfs.name.dir</name>

<value>/usr/local/hadoop/data/namenode</value>

</property>

<property>

<name>dfs.data.dir</name>

<value>/usr/local/hadoop/data/datanode</value>

</property>

<property>

<name>dfs.tmp.dir</name>

<value>/usr/local/hadoop/data/tmp</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

</configuration>

3、mapred-site.xml,指定hadoop运行在yarn之上

$ mv mapred-site.xml.template mapred-site.xml

$ vim mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

4、yarn-site.xml

$ vim yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>spark1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

5、slaves

$ vim slaves

spark1

spark2

spark3

6、hadoop-env.sh

vim hadoop-env.sh

输入jdk完整路径

export JAVA_HOME=/usr/local/bigdata/jdk

二、另外两台机器

使用拷贝命令将hadoop拷贝过去

$ cd /usr/local/bigdata

$ scp -r hadoop root@spark2:/usr/local/bigdata

$ scp -r hadoop root@spark3:/usr/local/bigdata

三、配置hadoop环境变量,三台机器均需要配置

export HADOOP_HOME=/usr/local/bigdata/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export HADOOP_COMMOM_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

四、启动hadoop集群

格式化namenode

$ hdfs namenode -format

$ start-dfs.sh

此时三台机器启动如下,才算成功

spark1

root@spark1:/usr/local/bigdata/hadoop/etc/hadoop# jps

4275 Jps

3859 NameNode

4120 SecondaryNameNode

3976 DataNode

spark2

root@spark2:/usr/local/bigdata/hadoop/etc/hadoop# jps

6546 DataNode

6612 Jps

spark3

root@spark3:/usr/local/bigdata/hadoop/etc/hadoop# jps

4965 DataNode

5031 Jps

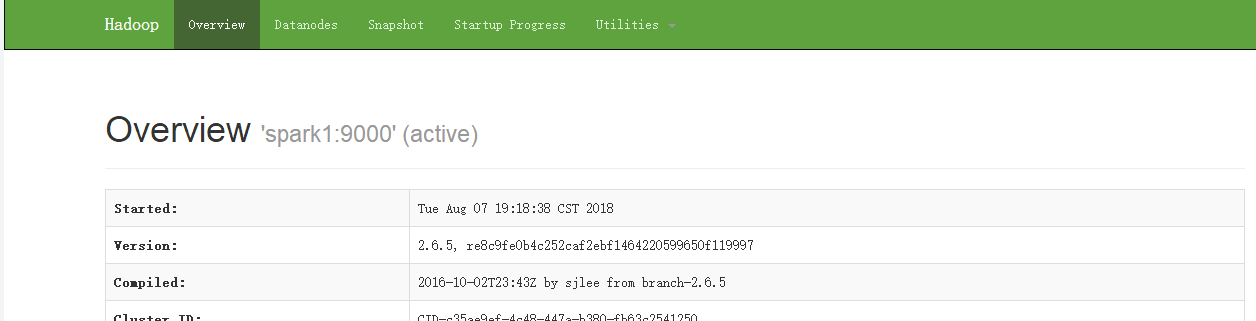

进入浏览器,访问http://spark1:50070

五、启动yarn集群

$ start-yarn.sh

此时spark1

root@spark1:/usr/local/bigdata/hadoop/etc/hadoop# jps

3859 NameNode

4803 Jps

4120 SecondaryNameNode

3976 DataNode

4443 ResourceManager

4365 NodeManager

spark2

root@spark2:/usr/local/bigdata/hadoop/etc/hadoop# jps

6546 DataNode

6947 Jps

6771 NodeManager

spark3

root@spark3:/usr/local/bigdata/hadoop/etc/hadoop# jps

5249 Jps

4965 DataNode

5096 NodeManager

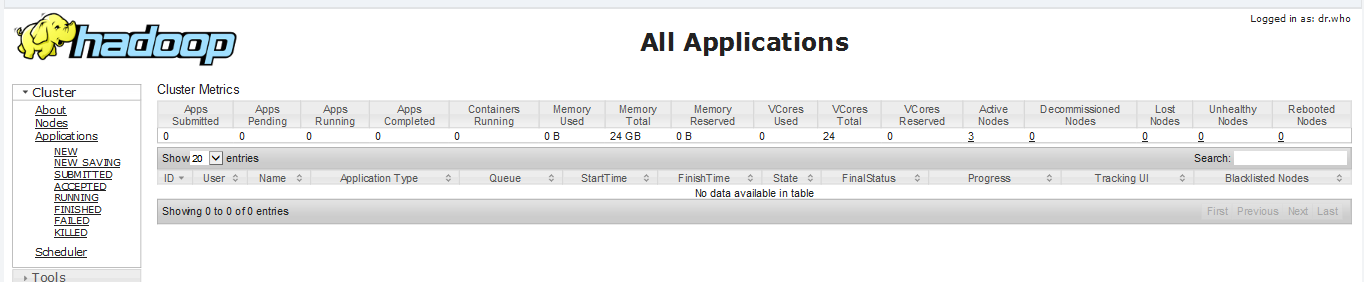

浏览器输入spark1:8088

spark集群搭建(三台虚拟机)——hadoop集群搭建(2)的更多相关文章

- Centos 7下VMware三台虚拟机Hadoop集群初体验

一.下载并安装Centos 7 传送门:https://www.centos.org/download/ 注:下载DVD ISO镜像 这里详解一下VMware安装中的两个过程 网卡配置 是Add ...

- 基于Docker快速搭建多节点Hadoop集群--已验证

Docker最核心的特性之一,就是能够将任何应用包括Hadoop打包到Docker镜像中.这篇教程介绍了利用Docker在单机上快速搭建多节点 Hadoop集群的详细步骤.作者在发现目前的Hadoop ...

- Hadoop4 利用VMware搭建自己的hadoop集群

前言: 前段时间自己学习如何部署伪分布式模式的hadoop环境,之前由于工作比较忙,学习的进度停滞了一段时间,所以今天抽出时间把最近学习的成果和大家分享一下. 本文要介绍的是如 ...

- 搭建简单的hadoop集群(译文)

本文翻译翻译自http://hadoop.apache.org/docs/r2.8.0/hadoop-project-dist/hadoop-common/ClusterSetup.html 具体的实 ...

- 在 Linux 服务器上搭建和配置 Hadoop 集群

实验条件:3台centos服务器,jdk版本1.8.0,Hadoop 版本2.8.0 注:hadoop安装和搭建过程中都是在用户lb的home目录下,master的主机名为host98,slave的主 ...

- Spark应用(app jar)发布到Hadoop集群的过程

记录了Spark,Hadoop集群的开启,关闭,以及Spark应用提交到Hadoop集群的过程,通过web端监控运行状态. 1.绝对路径开启集群 (每次集群重启,默认配置的hadoop集群中tmp文件 ...

- 虚拟机hadoop集群搭建

hadoop tar -xvf hadoop-2.7.3.tar.gz mv hadoop-2.7.3 hadoop 在hadoop根目录创建目录 hadoop/hdfs hadoop/hdfs/tm ...

- 搭建ubuntu版hadoop集群

用到的工具:VMware.hadoop-2.7.2.tar.jdk-8u65-linux-x64.tar.ubuntu-16.04-desktop-amd64.iso 1. 在VMware上安装ub ...

- Hadoop入门第四篇:手动搭建自己的hadoop小集群

前言 好几天没有更新了,本来是应该先写HDFS的相关内容,但是考虑到HDFS是我们后面所有学习的基础,而我只是简单的了解了一下而已,后面准备好好整理HDFS再写这块.所以大家在阅读这篇文章之前,请先了 ...

- Spark集群环境搭建——Hadoop集群环境搭建

Spark其实是Hadoop生态圈的一部分,需要用到Hadoop的HDFS.YARN等组件. 为了方便我们的使用,Spark官方已经为我们将Hadoop与scala组件集成到spark里的安装包,解压 ...

随机推荐

- PHP array_slice

1.函数的作用:返回数组中的部分区间的元素 2.函数的参数: @params array $array @params int $offset @params int $l ...

- Cocos2d-x 学习笔记(8) ActionManager

1. 概述 ActionManager管理所有的action,调度所有的action,删除指定的action.每个action对应一个node对象,action存储在actions中,actions和 ...

- Springboot读取Request参数的坑

[后端拿参数相关] 默认配置时, getInputStream()和getReader()一起使用会报错 使用两遍getInputStream(),第二遍会为空 当存在@RequestBody等注 ...

- Linux shell脚本笔记

shell 命令解释器 是用来解释用户对系统的操作 使用 cat /etc/shells 可以查看 系统安装的shell Linux 启动过程: BIOS -> MBR -> BootLo ...

- Juc1024小半年总结-面试篇

大家好,我叫Juc 这大概是我时隔2年度多 第一次以分享的形式发的第一篇公众号 今天是2019年10月26 本想在10月24就分享一下 可惜前面两天时间太忙... 很凑巧,今天我出来工作刚好满4个月, ...

- (一)如何理解java面向对象编程

哲学中,事物总是螺旋式上升,波浪式前进.因而编程也逐渐向人类更容易理解的方向前进,多年来人们苦苦追求的编程境界 : 高扩展性(extensibility),高复用性(reuseable).java语言 ...

- Vue系列---源码构建过程(四)

在了解源码如何构建之前,我们有必要了解下 项目中一个简单的目录结构如下: |---- vue | |---- dist # 打包后的存放文件目录 | |---- scripts # 存放构建相关的代码 ...

- 学习python3高阶函数笔记和demo

python的高阶函数的定义是:一个函数接收另一个函数作为参数,这种函数就称之为高阶函数 举一个最简单的例子: def text(a,b,c): return c(a)+c(b) print( tex ...

- 别再让你的微服务裸奔了,基于 Spring Session & Spring Security 微服务权限控制

微服务架构 网关:路由用户请求到指定服务,转发前端 Cookie 中包含的 Session 信息: 用户服务:用户登录认证(Authentication),用户授权(Authority),用户管理(R ...

- springboot pagehelper分页无效

springboot pagehelper分页无效 遇到的问题把所有的数据都查出来了 -然后跟踪代码发现PageHelper.startPage没有生效,生成的sql也没有分页的信息 依赖也引入了 & ...