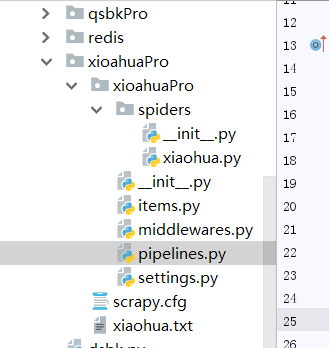

利用scrapy爬取文件后并基于管道化的持久化存储

我们在pycharm上爬取

首先我们可以在本文件打开命令框或在Terminal下创建

scrapy startproject xiaohuaPro ------------创建文件

scrapy genspider xiaohua www.xxx.com ----------创建执行文件

一.首先我们要进行数据的爬取

import scrapy

from xioahuaPro.items import XioahuaproItem class XiaohuaSpider(scrapy.Spider):

name = 'xiaohua'

start_urls=['http://www.521609.com/daxuemeinv/']

#生成一个通用的url模板

url = 'http://www.521609.com/daxuemeinv/list8%d.html'

pageNum =1 def parse(self, response):

li_list=response.xpath('//div[@class="index_img list_center"]/ul/li')

for li in li_list:

name = li.xpath('./a[2]/text() | ./a[2]/b/text()').extract_first()

img_url = 'http://www.521609.com'+li.xpath('./a[1]/img/@src').extract_first()

#实例化一个item类型的对象

item = XioahuaproItem()

item['name'] = name

item['img_url'] = img_url

#item提交给管道

yield item

# 对其他页码的url进行手动i请求的发送

if self.pageNum <= 24: ------爬取的页数

self.pageNum += 1

new_url = format(self.url%self.pageNum)

yield scrapy.Request(url=new_url,callback=self.parse)

之后再items.py文件下为item对象设置属性

将爬取到的所有信息全部设置为item的属性

# -*- coding: utf-8 -*- # Define here the models for your scraped items

#

# See documentation in:

# https://doc.scrapy.org/en/latest/topics/items.html import scrapy class XioahuaproItem(scrapy.Item):

# define the fields for your item here like:

name = scrapy.Field()

img_url = scrapy.Field()

二.写入pipelines.py内容

首先写入到自定义的文件里去

作用:将解析到的数据存储到某一个平台中。

import pymysql

from redis import Redis

class XioahuaproPipeline(object):

fp = None

def open_spider(self,spider):

print('开始爬虫!')

self.fp = open('./xiaohua.txt','w',encoding='utf-8')

#作用:实现持久化存储的操作

#该方法的item参数就可以接收爬虫文件提交过来的item对象

#该方法每接收一个item就会被调用一次(调用多次)

def process_item(self, item, spider):

name = item['name']

img_url = item['img_url']

self.fp.write(name+':'+img_url+'\n')

#返回值的作用:就是将item传递给下一个即将被执行的管道类

return item

#

def close_spider(self,spider):

print('结束爬虫!')

self.fp.close()

#

写到数据库里面,我们要在数据库里面创建个表(将mysql和redis都启动)

class MysqlPipeline(object):

conn = None

cursor = None

def open_spider(self, spider):

#解决数据库字段无法存储中文处理:alter table tableName convert to charset utf8;

self.conn = pymysql.Connect(host='127.0.0.1',port=3306,user='root',password='',db='test',charset='utf8')

print(self.conn)

def process_item(self, item, spider):

self.cursor = self.conn.cursor()

try:

self.cursor.execute('insert into xiaohua values ("%s","%s")'%(item['name'],item['img_url']))

self.conn.commit()

except Exception as e:

print(e)

self.conn.rollback()

return item

def close_spider(self, spider):

self.cursor.close()

self.conn.close()

在相同的文件下创建redis类写入数据

class RedisPipeline(object):

conn = None

def open_spider(self, spider):

self.conn = Redis(host='127.0.0.1',port=6379)

print(self.conn)

def process_item(self, item, spider):

dic = {

'name':item['name'],

'img_url':item['img_url']

}

print(str(dic))

self.conn.lpush('xiaohua',str(dic))

return item

def close_spider(self, spider):

pass

三.更改配置文件,在settings.py里面

#添加上这行代码

USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.86 Safari/537.36' # Obey robots.txt rules

ROBOTSTXT_OBEY = False -----改成False

ITEM_PIPELINES = {

'xioahuaPro.pipelines.XioahuaproPipeline': 300, ---对应文件

# 'xioahuaPro.pipelines.MysqlPipeline': 301, ----对应数据库

# 'xioahuaPro.pipelines.RedisPipeline': 302, -----对应redis

}

LOG_LEVEL = 'ERROR'

# CRITICAL --严重错误

#ERROR ---一般错误

#WARNING ---警告信息

#INFO ---一般信息

#DEBUG --调试信息

然后我们在终端去指定爬虫程序

scrapy crawl 名字(name对应的值)

利用scrapy爬取文件后并基于管道化的持久化存储的更多相关文章

- 利用Scrapy爬取所有知乎用户详细信息并存至MongoDB

欢迎大家关注腾讯云技术社区-博客园官方主页,我们将持续在博客园为大家推荐技术精品文章哦~ 作者 :崔庆才 本节分享一下爬取知乎用户所有用户信息的 Scrapy 爬虫实战. 本节目标 本节要实现的内容有 ...

- 利用scrapy爬取腾讯的招聘信息

利用scrapy框架抓取腾讯的招聘信息,爬取地址为:https://hr.tencent.com/position.php 抓取字段包括:招聘岗位,人数,工作地点,发布时间,及具体的工作要求和工作任务 ...

- 利用 Scrapy 爬取知乎用户信息

思路:通过获取知乎某个大V的关注列表和被关注列表,查看该大V和其关注用户和被关注用户的详细信息,然后通过层层递归调用,实现获取关注用户和被关注用户的关注列表和被关注列表,最终实现获取大量用户信息. 一 ...

- 爬虫实战--利用Scrapy爬取知乎用户信息

思路: 主要逻辑图:

- 以豌豆荚为例,用 Scrapy 爬取分类多级页面

本文转载自以下网站:以豌豆荚为例,用 Scrapy 爬取分类多级页面 https://www.makcyun.top/web_scraping_withpython17.html 需要学习的地方: 1 ...

- python scrapy爬取HBS 汉堡南美航运公司柜号信息

下面分享个scrapy的例子 利用scrapy爬取HBS 船公司柜号信息 1.前期准备 查询提单号下的柜号有哪些,主要是在下面的网站上,输入提单号,然后点击查询 https://www.hamburg ...

- 【转载】教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

原文:教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神 本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http:/ ...

- Scrapy爬取小说简单逻辑

Scrapy爬取小说简单逻辑 一 准备工作 1)安装Python 2)安装PIP 3)安装scrapy 4)安装pywin32 5)安装VCForPython27.exe ........... 具体 ...

- Scrapy爬取Ajax(异步加载)网页实例——简书付费连载

这两天学习了Scrapy爬虫框架的基本使用,练习的例子爬取的都是传统的直接加载完网页的内容,就想试试爬取用Ajax技术加载的网页. 这里以简书里的优选连载网页为例分享一下我的爬取过程. 网址为: ht ...

随机推荐

- html转换成pdf

指定html转换成pdf 安装插件: npm install --save html2canvas npm install jspdf --save 引入 plugins/ htmlToPdf.js ...

- PhpStorm中如何配置SVN,详细操作方法 - 郑加全的博客 - CSDN博客

登录|注册 郑加全的博客 目录视图 摘要视图 订阅 CSDN日报0711——<离开校园,入职阿里,开启新的程序人生> 征文 | 你会为 AI 转型么? ...

- jquery源码学习(一)——jquery结构概述以及如何合适的暴露全局变量

jQuery 源码学习是对js的能力提升很有帮助的一个方法,废话不说,我们来开始学习啦 我们学习的源码是jquery-2.0.3已经不支持IE6,7,8了,因为可以少学很多hack和兼容的方法. jq ...

- linux下监测进程是否存在

因为有的统计脚本需要执行很久,而有不能总去人工的检查进程是否在跑,所以就用shell脚本来循环监测进程是否存在 尝试了网上说的$?表示上一条命令返回值总是达不到预期的结果,后来直接改成用一个变量记录返 ...

- tes..

力扣刷题 二分查找法 二分查找法又称折半查找法. 优点:比较次数少,查找速度快,平均性能好: 缺点:要求待查表为有序表,且插入删除困难. 因此,折半查找方法适用于不经常变动而查找频繁的有序列表. 首先 ...

- Vue项目中出现Loading chunk {n} failed问题的解决方法

最近有个Vue项目中会偶尔出现Loading chunk {n} failed的报错,报错来自于webpack进行code spilt之后某些bundle文件lazy loading失败.但是这个问题 ...

- Python数据分析与展示[第三周](pandas简介与数据创建)

第三周的课程pandas 分析数据 http://pandas.pydata.org import pandas as pd 常与numpy matplotlib 一块定义 d=pd.Series(r ...

- SDUT-3377_数据结构实验之查找五:平方之哈希表

数据结构实验之查找五:平方之哈希表 Time Limit: 400 ms Memory Limit: 65536 KiB Problem Description 给定的一组无重复数据的正整数,根据给定 ...

- 关于sublime text2的一些问题(为解决)

1. 编写markdown文件后,如何转成pdf ? 2. 执行程序时,如何在控制台输入数据?

- Significance A and B for protein ratios

实验设计中,一般会做三个生物学重复来确保结果的准确性,尤其在下游分析中.但有时会遇到没有生物学重复,而又需要进行差异分析的情况,这时一般建议考虑foldchange即可,因为根本无法进行T-test等 ...