大数据系列之kafka-java实现

Java源码GitBub地址: https://github.com/fzmeng/kafka-demo

关于kafka安装步骤可见文章 http://www.cnblogs.com/cnmenglang/p/6520166.html

在上篇文章中使用shell 命令处理了kafka的消息生产与消息消费。下面介绍Java语言对kafka的消息生产与消息消费的处理。

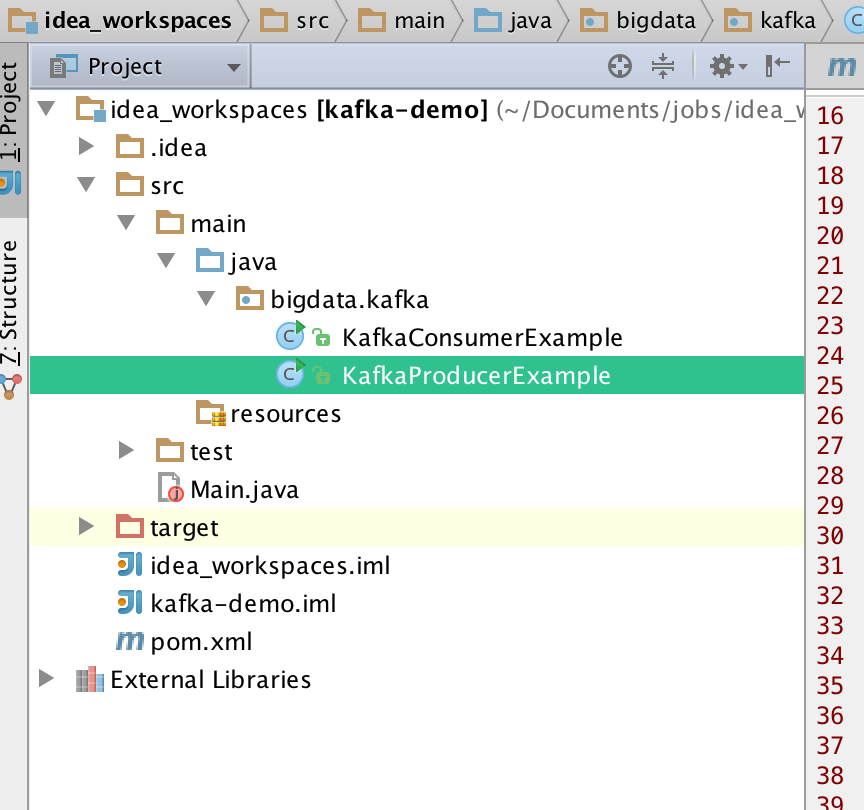

1.代码结构如图

2.pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.</modelVersion> <groupId>mfz.kafka</groupId>

<artifactId>kafka-demo</artifactId>

<version>1.0-SNAPSHOT</version> <properties>

<kafka.version>0.10.2.0</kafka.version>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>${kafka.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.kafka/kafka_2.11 -->

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka_2.</artifactId>

<version>${kafka.version}</version>

</dependency>

</dependencies> <build>

<plugins>

<plugin>

<artifactId>maven-assembly-plugin</artifactId>

<version>2.3</version>

<configuration>

<classifier>dist</classifier>

<appendAssemblyId>true</appendAssemblyId>

<descriptorRefs>

<descriptor>jar-with-dependencies</descriptor>

</descriptorRefs>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

</project>

2 . 生产者 KafKaProducerExample.java

package bigdata.kafka; import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord; import java.util.Properties; /**

* @author mengfanzhu

* @Package bigdata.kafka

* @Description: kafka生产者

* @date 17/3/8 17:20

*/

public class KafkaProducerExample { public void produceMessage()

{

Properties props = getConfig();

Producer<String, String> producer = new KafkaProducer<String, String>(props);

String topic="slavetest",key,value;

for (int i = 0; i < 1000; i++) {

key = "key"+i;

value="value"+i;

System.out.println("TOPIC: slavetest;发送KEY:"+key+";Value:"+value);

producer.send(new ProducerRecord<String, String>(topic, key,value));

try {

Thread.sleep(1000);

}

catch (InterruptedException e) {

e.printStackTrace();

}

} producer.close();

} // config

public Properties getConfig()

{

Properties props = new Properties();

props.put("bootstrap.servers", "10.211.55.3:9092");

props.put("acks", "all");

props.put("retries", 0);

props.put("batch.size", 16384);

props.put("linger.ms", 1);

props.put("buffer.memory", 33554432);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

return props;

} public static void main(String[] args)

{

KafkaProducerExample example = new KafkaProducerExample();

example.produceMessage();

}

}

3.消费者 KafkaConsumerExample.java

package bigdata.kafka; import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import org.apache.kafka.common.errors.WakeupException; import java.util.ArrayList;

import java.util.Arrays;

import java.util.List;

import java.util.Properties;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

import java.util.concurrent.TimeUnit;

import java.util.concurrent.atomic.AtomicBoolean; /**

* @author mengfanzhu

* @Package bigdata.kafka

* @Description: kafka 消费者

* @date 17/3/8 17:21

*/

public class KafkaConsumerExample { //config

public static Properties getConfig()

{

Properties props = new Properties();

props.put("bootstrap.servers", "10.211.55.3:9092");

props.put("group.id", "testGroup");

props.put("enable.auto.commit", "true");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer"); return props;

} public void consumeMessage()

{

// launch 3 threads to consume

int numConsumers = 1;

final String topic = "slavetest";

final ExecutorService executor = Executors.newFixedThreadPool(numConsumers);

final List<KafkaConsumerRunner> consumers = new ArrayList<KafkaConsumerRunner>();

for (int i = 0; i < numConsumers; i++) {

KafkaConsumerRunner consumer = new KafkaConsumerRunner(topic);

consumers.add(consumer);

executor.submit(consumer);

} Runtime.getRuntime().addShutdownHook(new Thread()

{

@Override

public void run()

{

for (KafkaConsumerRunner consumer : consumers) {

consumer.shutdown();

}

executor.shutdown();

try {

executor.awaitTermination(5000, TimeUnit.MILLISECONDS);

}

catch (InterruptedException e) {

e.printStackTrace();

}

}

});

} // Thread to consume kafka data

public static class KafkaConsumerRunner

implements Runnable

{

private final AtomicBoolean closed = new AtomicBoolean(false);

private final KafkaConsumer<String, String> consumer;

private final String topic; public KafkaConsumerRunner(String topic)

{

Properties props = getConfig();

consumer = new KafkaConsumer<String, String>(props);

this.topic = topic;

} public void handleRecord(ConsumerRecord record)

{

System.out.println("name: " + Thread.currentThread().getName() + " ; topic: " + record.topic() + " ; offset" + record.offset() + " ; key: " + record.key() + " ; value: " + record.value());

} public void run()

{

try {

// subscribe 订阅`topic

consumer.subscribe(Arrays.asList(topic));

while (!closed.get()) {

//read data

ConsumerRecords<String, String> records = consumer.poll(10000);

// Handle new records

for (ConsumerRecord<String, String> record : records) {

handleRecord(record);

}

}

}

catch (WakeupException e) {

// Ignore exception if closing

e.printStackTrace();

if (!closed.get()) {

throw e;

}

}

finally {

consumer.close();

}

} // Shutdown hook which can be called from a separate thread

public void shutdown()

{

closed.set(true);

consumer.wakeup();

}

} public static void main(String[] args)

{

KafkaConsumerExample example = new KafkaConsumerExample();

example.consumeMessage();

}

}

4.运行效果

附加:代码不多,但是这样直接运行可能会导致消息消费失败,或是异常 "...Failed to send messages after 3 tries.."。原因是因为远程链接kafka时需要指定broker的地址(严格来说是所监听的网络接口,或者网卡)。

解决方案:

修改config/service.properties文件,默认是注释的。

大数据系列之kafka-java实现的更多相关文章

- 大数据系列之kafka监控kafkaoffsetmonitor安装

1.下载kafkaoffsetmonitor的jar包,可以到github搜索kafkaoffsetmonitor,第一个就是,里面可以下载编译好了的包. KafkaOffsetMonitor-ass ...

- 大数据系列之Kafka安装

先简单说下安装kafka的流程..(可配置多个zookeeper,这篇文只说一个zookeeper场景) 1.环境配置:jdk1.7+ (LZ用的是jdk1.8) 2.资料准备:下载 kafka_2. ...

- 大数据系列之Flume+kafka 整合

相关文章: 大数据系列之Kafka安装 大数据系列之Flume--几种不同的Sources 大数据系列之Flume+HDFS 关于Flume 的 一些核心概念: 组件名称 功能介绍 Agent ...

- 大数据系列(3)——Hadoop集群完全分布式坏境搭建

前言 上一篇我们讲解了Hadoop单节点的安装,并且已经通过VMware安装了一台CentOS 6.8的Linux系统,咱们本篇的目标就是要配置一个真正的完全分布式的Hadoop集群,闲言少叙,进入本 ...

- 大数据系列(2)——Hadoop集群坏境CentOS安装

前言 前面我们主要分析了搭建Hadoop集群所需要准备的内容和一些提前规划好的项,本篇我们主要来分析如何安装CentOS操作系统,以及一些基础的设置,闲言少叙,我们进入本篇的正题. 技术准备 VMwa ...

- 大数据系列之并行计算引擎Spark介绍

相关博文:大数据系列之并行计算引擎Spark部署及应用 Spark: Apache Spark 是专为大规模数据处理而设计的快速通用的计算引擎. Spark是UC Berkeley AMP lab ( ...

- 大数据系列之数据仓库Hive安装

Hive系列博文,持续更新~~~ 大数据系列之数据仓库Hive原理 大数据系列之数据仓库Hive安装 大数据系列之数据仓库Hive中分区Partition如何使用 大数据系列之数据仓库Hive命令使用 ...

- 大数据系列之数据仓库Hive命令使用及JDBC连接

Hive系列博文,持续更新~~~ 大数据系列之数据仓库Hive原理 大数据系列之数据仓库Hive安装 大数据系列之数据仓库Hive中分区Partition如何使用 大数据系列之数据仓库Hive命令使用 ...

- 大数据系列之分布式计算批处理引擎MapReduce实践-排序

清明刚过,该来学习点新的知识点了. 上次说到关于MapReduce对于文本中词频的统计使用WordCount.如果还有同学不熟悉的可以参考博文大数据系列之分布式计算批处理引擎MapReduce实践. ...

- 大数据系列之数据仓库Hive原理

Hive系列博文,持续更新~~~ 大数据系列之数据仓库Hive原理 大数据系列之数据仓库Hive安装 大数据系列之数据仓库Hive中分区Partition如何使用 大数据系列之数据仓库Hive命令使用 ...

随机推荐

- hdu 6435 CSGO(最大曼哈顿距离)

题目链接 Problem Description You are playing CSGO. There are n Main Weapons and m Secondary Weapons in C ...

- bzoj2669-局部极小值

题意 有一个 \(n\times m\) 的矩阵,其中每个数都是 \([1,n\times m]\) 中的一个,不会重复.有一些地方的值比周围的8个位置都小(如果有的话).给出这些位置,求这样的矩阵有 ...

- Win10 安装 Linux 子系统

Win10 安装 Linux 子系统 因为最近要使用Linux搭服务器,但是用远程的话延迟很烦,用双系统切换很麻烦,用虚拟机又会有点卡,刚好Windows10最近更新了正式版的WSL(windows下 ...

- BZOJ3524 & LOJ2432:[POI2014]代理商Couriers——题解

https://www.lydsy.com/JudgeOnline/problem.php?id=3524 https://loj.ac/problem/2432 给一个长度为n的序列a.1≤a[i] ...

- Unity3D手游开发日记(4) - 适合移动平台的热浪扭曲

热浪扭曲效果的实现,分两部分,一是抓图,二是扭曲扰动.其中难点在于抓图的处理,网上的解决方案有两种,在移动平台都有很多问题,只好自己实现了一种新的方案,效果还不错. 网上方案1. 用GrabPass抓 ...

- msf下的LNK漏洞(CVE-2017-8464)利用

0x01 前言 RCE漏洞存在于Windows处理LNK文件的环节.攻击者利用漏洞可以获得与本地用户相同的用户权限.被使用此漏洞攻击时,用户权限较少的账户相较管理员权限的用户受到的影响更小. 攻击者可 ...

- 解题:POI 2018 Prawnicy

题面 网上好像都是堆的做法啊......我这个不算离散化是$O(n)$的说(虽然有一坨vector可能不开O2会爆炸) 题目即是让我们求是否存在一个最长的是不少于$k$个给出区间子集的区间,如果存在输 ...

- bzoj3748 Kwadraty

Claris 当然是要用来%的 但是,,其他dalao,,比如JL的红太阳commonc.题解能不能稍微加几句话,蒟蒻看不懂啊. 在这里解释一下,Claris的题解.(因为我弱,想了半天才明白,所以觉 ...

- oracle-DECODE()函数

DECODE()函数 DECODE(value, if1, then1, if2,then2, if3,then3, . . . else ) 含义解释: DECODE(条件,值1,翻译值1,值2,翻 ...

- Codeforces Round #271 (Div. 2) D 简单dp

D. Flowers time limit per test 1.5 seconds memory limit per test 256 megabytes input standard input ...