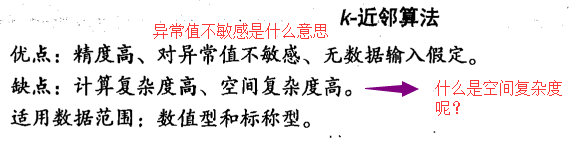

《机器学习实战》---第二章 k近邻算法 kNN

下面的代码是在python3中运行,

# -*- coding: utf-8 -*-

"""

Created on Tue Jul 3 17:29:27 2018 @author: Administrator

""" from numpy import * #NumPy

import operator #运算符模块 def createDataSet(): #这个只是导入数据的函数

group=array([[1.0,1.1],[1.0,1.0],[0,0],[0,0.1]]) #这个是4行2列的数组

labels=['A','A ','B','B']

return group ,labels def classify0 (inX,dataSet,labels,k) : #这个是k近邻算法的实现,要注意传入的参数有哪些.

#1,用于分类的输入向量inX;2,输入的训练样本集dataSet;3,标签向量labels;4,最后的参数k用于选择最近邻居的数目;

dataSetSize=dataSet.shape[0] #其中标签向量的元素数目和矩阵dataSet的行数相同.

diffMat=tile(inX,(dataSetSize,1))-dataSet #这里是调用了numpy的函数,tile diffMat已经是数组了 下面就是一些算法了(欧式距离的算法). 这里就是数组运算了,为了避免使用过多的for,这样可能会提升运行速度?

sqDiffMat=diffMat**2 #对数组diffMat的每个元素进行平方. python的写法就是这样简单.

sqDistances=sqDiffMat.sum(axis=1) #axis=1,表示的是按行相加. axis=0表示按列相加.

distances=sqDistances**0.5 #这个是开平方

sortedDistIndicies=distances.argsort() #返回的是从小到大的索引.关于变量的建立,还是把我不准,这个直接给了个变量名,并没有标注类型[],比如最小的数据是在第3个位置,就是2,那么第一个元素值就是2

classCount={}

for i in range(k): #这里可以认为是投票算法,要弄清它的输入和输出是什么.

voteIlabel=labels[sortedDistIndicies[i]] #确定前k个距离最小的主要分类,sortedDistIndicies[i]其实返回的是样本的位置,

classCount[voteIlabel]=classCount.get(voteIlabel,0)+1

sortedClassCount=sorted(classCount.items(),key=operator.itemgetter(1),reverse=True) #把'iteritems'改成了tiems,就可以在python3上运行了.

return sortedClassCount[0][0] #返回发生频率最高的,标签,,,,注意,这里返回的是标签,其实我们一直想要得到的也是某个东西的标签.返回的是我们想要的东西. group,labels=createDataSet()

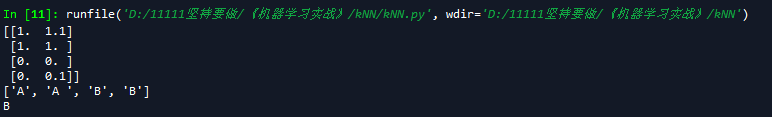

print(group)

print(labels) a=classify0([0,0],group,labels,3)

print(a)

运行结果

《机器学习实战》---第二章 k近邻算法 kNN的更多相关文章

- <机器学习实战>读书笔记--k邻近算法KNN

k邻近算法的伪代码: 对未知类别属性的数据集中的每个点一次执行以下操作: (1)计算已知类别数据集中的点与当前点之间的距离: (2)按照距离递增次序排列 (3)选取与当前点距离最小的k个点 (4)确定 ...

- 机器学习(1)——K近邻算法

KNN的函数写法 import numpy as np from math import sqrt from collections import Counter def KNN_classify(k ...

- k近邻算法(KNN)

k近邻算法(KNN) 定义:如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别. from sklearn.model_selection ...

- 《机实战》第2章 K近邻算法实战(KNN)

1.准备:使用Python导入数据 1.创建kNN.py文件,并在其中增加下面的代码: from numpy import * #导入科学计算包 import operator #运算符模块,k近邻算 ...

- 机器学习(四) 分类算法--K近邻算法 KNN (上)

一.K近邻算法基础 KNN------- K近邻算法--------K-Nearest Neighbors 思想极度简单 应用数学知识少 (近乎为零) 效果好(缺点?) 可以解释机器学习算法使用过程中 ...

- 机器学习(四) 机器学习(四) 分类算法--K近邻算法 KNN (下)

六.网格搜索与 K 邻近算法中更多的超参数 七.数据归一化 Feature Scaling 解决方案:将所有的数据映射到同一尺度 八.scikit-learn 中的 Scaler preprocess ...

- 一看就懂的K近邻算法(KNN),K-D树,并实现手写数字识别!

1. 什么是KNN 1.1 KNN的通俗解释 何谓K近邻算法,即K-Nearest Neighbor algorithm,简称KNN算法,单从名字来猜想,可以简单粗暴的认为是:K个最近的邻居,当K=1 ...

- SIGAI机器学习第七集 k近邻算法

讲授K近邻思想,kNN的预测算法,距离函数,距离度量学习,kNN算法的实际应用. KNN是有监督机器学习算法,K-means是一个聚类算法,都依赖于距离函数.没有训练过程,只有预测过程. 大纲: k近 ...

- k近邻算法(knn)的c语言实现

最近在看knn算法,顺便敲敲代码. knn属于数据挖掘的分类算法.基本思想是在距离空间里,如果一个样本的最接近的k个邻居里,绝大多数属于某个类别,则该样本也属于这个类别.俗话叫,"随大流&q ...

随机推荐

- js---14公有私有成员方法

var ns1 = {}; //命名空间 ns1.ns11 = {};//子命名空间 ns1.module1 = {name:"a",m:function(){}}; consol ...

- 配置Lotus Domino集群视频详解

IBM Lotus Domino Server 有个最重要的高可用特新就是集群,它对于任何使用 Domino 服务器的组织,让用户能够持续访问它们的数据库,保证业务不间断运行.下面通过两个视频来学习如 ...

- 分享一个jquery实现的双向选择组件

<html><head> <meta charset="utf-8"> <title>数据删选组件</title> &l ...

- inode与ln命令

inode可以看: http://www.cnblogs.com/itech/archive/2012/05/15/2502284.html 每个inode节点的大小,一般是128字节或256字节.i ...

- Android 使用开源库载入网络图片

Android 使用开源库载入网络图片,使用开源库载入图片.单击listview弹出popupwindow弹出框详情查看: Android 单击listview弹出popupwindow弹出框 ,里面 ...

- Linux下设置ip和主机名进行绑定

1:输入命令gedit /etc/hosts 这样你就打开了一个文本,然后在文本的末尾进行加入例如以下: ip地址 主机名 192.168.0.125 h ...

- JavaScript的子集和超集

1.JavaScript子集 JavaScript子集的定义大部分都是出于安全考虑,仅仅有使用这门语言的一个安全的子集编写脚本,才干让代码运行得更安全.更稳定.比方怎样更安全地运行一段由不可信第三方提 ...

- ViewPager 入门一

使用ViewPager能够得到不同view的切换效果 例如以下图,实现了四个view间的相互滑动 一.新建项目,引入ViewPager控件 ViewPager.它是google SDk中自带的一个附加 ...

- Jodd-vtor验证框架

VTor是一个编程式验证框架,适用于任意java对象的验证.它是一个快速.微型的.专注于验证的框架.也可以通过注解或者手动设置验证条件.验证条件也可以在profile中分组.VTor是可扩展的,用户很 ...

- Objective-C基础笔记(1)基本概念和第一个程序

一.基本概念 Objective-C(简称OC)是iOS开发的核心语言,苹果公司在维护,在开发过程中也会配合着使用C语言.C++,OC主要负责UI界面,C语言.C++可用于图形处理.C语言是面向过程的 ...