python-scrapy爬取某招聘网站(二)

首先要准备python3+scrapy+pycharm

一、首先让我们了解一下网站

拉勾网https://www.lagou.com/

和Boss直聘类似的网址设计方式,与智联招聘不同,它采用普通的页面加载方式

我们采用scrapy中的crawlspider爬取

二、创建爬虫程序

scrapy startproject lagou

创建爬虫文件

scrapy genspider -t crawl zhaopin "www.lagou.com"

由此爬虫程序创建完毕

三、编写爬虫程序

出于演示和测试,我们这次只爬取一条数据。

items文件

import scrapy class BossItem(scrapy.Item):

# 岗位名称

jobName = scrapy.Field()

zhaopin.py爬虫文件

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from boss.items import BossItem class ZhipinSpider(CrawlSpider):

name = 'zhipin'

allowed_domains = ['www.lagou.com']

start_urls = ['https://www.lagou.com'] rules = (

Rule(LinkExtractor(allow=r'com/zhaopin/\w+/'), callback='zhilianParse', follow=False), #采用正则匹配的方式,获取网页url

) def zhilianParse(self, response):

datas = response.xpath('//ul[@class="item_con_list"]/li') #通过xpath方式获取要爬取的域

for data in datas: #逐层迭代

item = BossItem()

# 岗位名称

item["jobName"] = data.xpath('//div//div/a/h3[1]/text()').get() #定位爬取信息

yield item #rule会迭代所有的url不需要再写回调函数

管道文件

import json

import os

class BossPipeline(object):

def __init__(self):

self.filename = open("Boss.json", "wb")

self.path = "G:\images\p"

if not os.path.exists(self.path):

os.mkdir(self.path) #判断路径

def process_item(self, item, spider):

# 岗位名称

jobName = item['jobName']

js = json.dumps(dict(item), ensure_ascii=False) + "\n"

self.filename.write(js.encode("utf-8"))

return item

def __close__(self):

self.filename.close()

配置settings文件

DEFAULT_REQUEST_HEADERS = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36',

}

ITEM_PIPELINES = {

'boss.pipelines.BossPipeline': 300,

}

LOG_FILE="log.log" #放日志文件用的,可有可无

ROBOTSTXT_OBEY = False

四、启动爬虫

scrapy crawl zhaopin

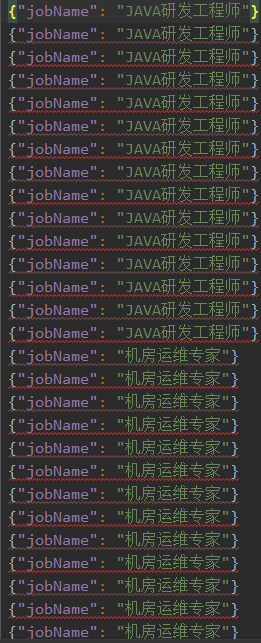

爬取结果

在第一篇文章中讲了如何存入mysql,这里我就不多赘述了,大家自行查阅。

python-scrapy爬取某招聘网站(二)的更多相关文章

- Python——Scrapy爬取链家网站所有房源信息

用scrapy爬取链家全国以上房源分类的信息: 路径: items.py # -*- coding: utf-8 -*- # Define here the models for your scrap ...

- python scrapy爬取前程无忧招聘信息

使用scrapy框架之前,使用以下命令下载库: pip install scrapy -i https://pypi.tuna.tsinghua.edu.cn/simple 1.创建项目文件夹 scr ...

- scrapy爬取西刺网站ip

# scrapy爬取西刺网站ip # -*- coding: utf-8 -*- import scrapy from xici.items import XiciItem class Xicispi ...

- python scrapy爬取HBS 汉堡南美航运公司柜号信息

下面分享个scrapy的例子 利用scrapy爬取HBS 船公司柜号信息 1.前期准备 查询提单号下的柜号有哪些,主要是在下面的网站上,输入提单号,然后点击查询 https://www.hamburg ...

- Python轻松爬取Rosimm写真网站全部图片

RosimmImage 爬取Rosimm写真网站图片 有图有真相 def main_start(url): """ 爬虫入口,主要爬取操作 ""&qu ...

- 利用python实现爬虫爬取某招聘网站,北京地区岗位名称包含某关键字的所有岗位平均月薪

#通过输入的关键字,爬取北京地区某岗位的平均月薪 # -*- coding: utf-8 -*- import re import requests import time import lxml.h ...

- Python网络爬虫 | Scrapy爬取妹子图网站全站照片

根据现有的知识,写了一个下载妹子图(meizitu.com)Scrapy脚本,把全站两万多张照片下载到了本地. 网站的分析 网页的网址分析 打开网站,发现网页的网址都是以 http://www.mei ...

- Python Scrapy 爬取煎蛋网妹子图实例(二)

上篇已经介绍了 图片的爬取,后来觉得不太好,每次爬取的图片 都在一个文件下,不方便区分,且数据库中没有爬取的时间标识,不方便后续查看 数据时何时爬取的,所以这里进行了局部修改 修改一:修改爬虫执行方式 ...

- 爬虫框架之Scrapy——爬取某招聘信息网站

案例1:爬取内容存储为一个文件 1.建立项目 C:\pythonStudy\ScrapyProject>scrapy startproject tenCent New Scrapy projec ...

随机推荐

- Fiddler 4 对app接口抓取

一.先打开模拟器 二.在Fiddler 4 选项中修改端口号和去掉一个勾选 三.在终端查看ip 输入ipconfig 四.点开模拟器的设置 五.点击WLAN 六.长按网络,修改网络 七.输入ip端口号 ...

- 在django中使用原生sql语句

raw # row方法:(掺杂着原生sql和orm来执行的操作) res = CookBook.objects.raw('select id as nid from epos_cookbook whe ...

- 第8.6节 Python类中的__new__方法深入剖析:调用父类__new__方法参数的困惑

上节<第8.5节 Python类中的__new__方法和构造方法__init__关系深入剖析:执行顺序及参数关系案例详解>通过案例详细分析了两个方法的执行顺序,不知大家是否注意到了,在上述 ...

- PyQt(Python+Qt)学习随笔:QDockWidget停靠部件的setWidget和widget方法

专栏:Python基础教程目录 专栏:使用PyQt开发图形界面Python应用 专栏:PyQt入门学习 老猿Python博文目录 QDockWidget对象由一个标题栏和内容区域组成.QDockWid ...

- Xmind Invalid Configuarton Location(the configuarton area is not writable)

今天在安装Xmind的时候,发现如下错误,原因:配置问题 步骤如下: 1.找到XMind安装目录下的文件XMind.ini2.文件中的内容替换:将:-configuration./configurat ...

- 《深入理解计算机系统》(CSAPP)读书笔记 —— 第一章 计算机系统漫游

本章通过跟踪hello程序的生命周期来开始对计算机系统进行学习.一个源程序从它被程序员创建开始,到在系统上运行,输出简单的消息,然后终止.我们将沿着这个程序的生命周期,简要地介绍一些逐步出现的关键概念 ...

- Linq to SQL 语法整理(子查询 & in操作 & join )

子查询 描述:查询订单数超过5的顾客信息 查询句法: var 子查询 = from c in ctx.Customers where (from o in ctx.Orders group o by ...

- 学习JUC源码(2)——自定义同步组件

前言 在之前的博文(学习JUC源码(1)--AQS同步队列(源码分析结合图文理解))中,已经介绍了AQS同步队列的相关原理与概念,这里为了再加深理解ReentranLock等源码,模仿构造同步组件的基 ...

- 06-flask-文件上传案例

前端代码 Demo.html <!DOCTYPE html> <html lang="en"> <head> <meta charset= ...

- Spring(一)--简介

一.概述(什么是spring): Spring是分层的Java SE/EE应用full-stack(一站式)轻量级开源框架.他解决的是业务逻辑层和其他各层的松耦合问题,将面向接口的编程思想贯穿整个系统 ...