【python】使用爬虫爬取动漫之家漫画全部更新信息

本篇仅在于交流学习

网站名称为:

https://manhua.dmzj.com/

1.首先将相应的库导入:

import requests

from lxml import etree

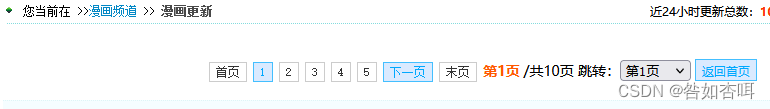

2.确定漫画更新页面上限:

第一页

第一页

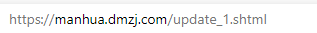

第二页

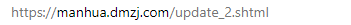

第二页

可以确定页面转换是通过修改数字改变网页的

3.使用for循环遍历页面:

for page in range(1,11):

url = 'https://manhua.dmzj.com/update_%s.shtml' % (page * 1)

print(url)

得到漫画更新全网页链接

4.截取网站信息进行分析:

heads = {}

heads['User-Agent'] = '用自己的网页头部'

html = requests.get(url=url, headers=heads).text

list = etree.HTML(html)

5.截取信息:

分析网页内容:

l = list.xpath("//div[@class='boxdiv1']")

for info in l:

title = info.xpath('div/ul/li/a/@title')[0] # 作品名

doc = info.xpath('div/ul/li/text()')[1] # '作者:'

name = info.xpath('div/ul/li/span/text()')[0] # 作者名·-

type = info.xpath('div/ul/li/text()')[2] # 类型

link = info.xpath('div/ul/li/a/@href')[0] # 作品链接

link = 'https://manhua.dmzj.com/' + link

newlink = info.xpath('div/ul/li/a/@href')[1] # 最新作品链接

newlink = 'https://manhua.dmzj.com/' + newlink

buff = info.xpath('div/ul/li/text()')[5] # 作品状态

print(title + " " + doc + name + " " + type + " " + link + " " + buff + " " + newlink + " ")x

效果:

6.完整代码:

import requests

from lxml import etree for page in range(1,11):

url = 'https://manhua.dmzj.com/update_%s.shtml' % (page * 1)

print(url)

heads = {}

heads['User-Agent'] = '用自己的头部'

html = requests.get(url=url, headers=heads).text

list = etree.HTML(html)

l = list.xpath("//div[@class='boxdiv1']")

for info in l:

title = info.xpath('div/ul/li/a/@title')[0] # 作品名 doc = info.xpath('div/ul/li/text()')[1] # '作者:' name = info.xpath('div/ul/li/span/text()')[0] # 作者名·- type = info.xpath('div/ul/li/text()')[2] # 类型 link = info.xpath('div/ul/li/a/@href')[0] # 作品链接

link = 'https://manhua.dmzj.com/' + link newlink = info.xpath('div/ul/li/a/@href')[1] # 最新作品链接

newlink = 'https://manhua.dmzj.com/' + newlink buff = info.xpath('div/ul/li/text()')[5] # 作品状态 print(title + " " + doc + name + " " + type + " " + link + " " + buff + " " + newlink + " ")

【python】使用爬虫爬取动漫之家漫画全部更新信息的更多相关文章

- 如何利用Python网络爬虫爬取微信朋友圈动态--附代码(下)

前天给大家分享了如何利用Python网络爬虫爬取微信朋友圈数据的上篇(理论篇),今天给大家分享一下代码实现(实战篇),接着上篇往下继续深入. 一.代码实现 1.修改Scrapy项目中的items.py ...

- 利用Python网络爬虫爬取学校官网十条标题

利用Python网络爬虫爬取学校官网十条标题 案例代码: # __author : "J" # date : 2018-03-06 # 导入需要用到的库文件 import urll ...

- 通过爬虫爬取四川省公共资源交易平台上最近的招标信息 --- URLConnection

通过爬虫爬取公共资源交易平台(四川省)最近的招标信息 一:引入JSON的相关的依赖 <dependency> <groupId>net.sf.json-lib< ...

- Python多线程爬虫爬取电影天堂资源

最近花些时间学习了一下Python,并写了一个多线程的爬虫程序来获取电影天堂上资源的迅雷下载地址,代码已经上传到GitHub上了,需要的同学可以自行下载.刚开始学习python希望可以获得宝贵的意见. ...

- Python简易爬虫爬取百度贴吧图片

通过python 来实现这样一个简单的爬虫功能,把我们想要的图片爬取到本地.(Python版本为3.6.0) 一.获取整个页面数据 def getHtml(url): page=urllib.requ ...

- python制作爬虫爬取京东商品评论教程

作者:蓝鲸 类型:转载 本文是继前2篇Python爬虫系列文章的后续篇,给大家介绍的是如何使用Python爬取京东商品评论信息的方法,并根据数据绘制成各种统计图表,非常的细致,有需要的小伙伴可以参考下 ...

- 如何用Python网络爬虫爬取网易云音乐歌曲

今天小编带大家一起来利用Python爬取网易云音乐,分分钟将网站上的音乐down到本地. 跟着小编运行过代码的筒子们将网易云歌词抓取下来已经不再话下了,在抓取歌词的时候在函数中传入了歌手ID和歌曲名两 ...

- python 小爬虫爬取博客文章初体验

最近学习 python 走火入魔,趁着热情继续初级体验一下下爬虫,以前用 java也写过,这里还是最初级的爬取html,都没有用html解析器,正则等...而且一直在循环效率肯定### 很低下 imp ...

- 【Python】Python简易爬虫爬取百度贴吧图片

通过python 来实现这样一个简单的爬虫功能,把我们想要的图片爬取到本地.(Python版本为3.6.0) 一.获取整个页面数据 def getHtml(url): page=urllib.requ ...

- python简单爬虫爬取百度百科python词条网页

目标分析:目标:百度百科python词条相关词条网页 - 标题和简介 入口页:https://baike.baidu.com/item/Python/407313 URL格式: - 词条页面URL:/ ...

随机推荐

- MySql.Data 链接MySql数据库 查询语句中带有中文的奇怪问题

首先Nuget管理器安装MySql.Data 1.ado.net 直接链接 public static void Test() { MySqlConnection myconn = null; MyS ...

- 利用easyExcel生成excel并上传文件服务器(单独设置表头)

结合相关easyExcel的相关信息//上传服务器方法,返回url链接地址public String exportToMinIO(List<aaaDto> list) { String p ...

- Jx9嵌入式脚本语言基本用法

Jx9是一种嵌入式脚本语言,可用于编写嵌入式脚本和扩展. 以下是一些使用Jx9的示例: 1. 计算器 Jx9可以轻松实现一个计算器.例如: ```print("Enter two numbe ...

- 计网学习笔记三 MAC与LAN

在上一讲中,我们学习了链路层可以提供的服务:framing,link access,reliable delivery,error detection&correction.这一讲我们从lin ...

- Java面试——RPC

一.RPC 服务的原理 [1]Socket 套接字:网络上的两个程序通过一个双向的通信连接实现数据的交换,这个链接的一端称为 Socket.可以实现不同计算机之间的通信,是网络编程接口的具体实现.So ...

- Module not found: Error: Can't resolve 'pubsub-js'

包未安装或者包版本过新,再者安装位置有误. 我安装各种工具库或者其他包时有个 -g 到全局的习惯,觉得装到全局时在文件夹中何时何处都可以用. 在子孙文件夹中引入时依赖会在子孙和文件根目录的node_m ...

- Neo4j常用操作——Cypher查询语言

1. 删除数据库中以往的图,确保一个空白的环境进行操作: MATCH (n) DETACH DELETE n # 要想删除数据库的话直接删除文件即可 2. 创建一个人物节点: CREATE (n:Pe ...

- Go 语言 new 和 make 关键字的区别

原文链接: Go 语言 new 和 make 关键字的区别 本篇文章来介绍一道非常常见的面试题,到底有多常见呢?可能很多面试的开场白就是由此开始的.那就是 new 和 make 这两个内置函数的区别. ...

- Ubuntu桌面顶端没有网络图标

1 问题描述 刚装完新的linux系统后发现桌面顶部没有出现网络连接图标,网络无法进行连接配置. 2 解决方案 打开终端执行命令 nmcli network on或者sudo nmcli networ ...

- 鸿蒙开发学习笔记-UIAbility-Router页面跳转接口源码分析

在鸿蒙开发中,UIAbility的跳转使用 router 方法. 在使用的时候需导入 import router from '@ohos.router'; 该方法接口成员如下: 1.interface ...