scrapydweb的初步使用(管理分布式爬虫)

https://github.com/my8100/files/blob/master/scrapydweb/README_CN.md

一.安装配置

1、请先确保所有主机都已经安装和启动 Scrapyd,如果需要远程访问 Scrapyd,则需将 Scrapyd 配置文件中的 bind_address 修改为 bind_address = 0.0.0.0,然后重启 Scrapyd。

2、开发主机或任一台主机安装 ScrapydWeb: pip install scrapydweb

3、运行命令 scrapydweb -h,将在当前工作目录生成配置文件 scrapydweb_settings.py,可用于下文的自定义配置。

4、启用 HTTP 基本认证

ENABLE_AUTH = True

USERNAME = 'username'

PASSWORD = 'password'

- 添加 Scrapyd server,支持字符串和元组两种配置格式,支持添加认证信息和分组/标签:

SCRAPYD_SERVERS = [

#'127.0.0.1:6800',

# 'username:password@localhost:6801#group',

'106.12.112.139:6800',

]

报错情况:(在)

In order to automatically run LogParser at startup, you have to set up the SCRAPYD_LOGS_DIR option first.

Otherwise, set 'ENABLE_LOGPARSER = False' if you are not running any Scrapyd service on the current ScrapydWeb host.

Note that you can run the LogParser service separately via command 'logparser' as you like.

Check and update your settings in F:/scrapyweb/scrapydweb_settings_v8.py

如果出现这样的错误去配置文件中把

'ENABLE_LOGPARSER = True'改成False

6.通过运行命令 scrapydweb 启动 ScrapydWeb

二.页面管理

通过浏览器访问并登录 http://127.0.0.1:5000

Overview 页面自动输出所有 Scrapyd server 的运行状态

通过分组和过滤可以自由选择若干台 Scrapyd server,调用 Scrapyd 提供的所有 HTTP JSON API,实现一次操作,批量执行

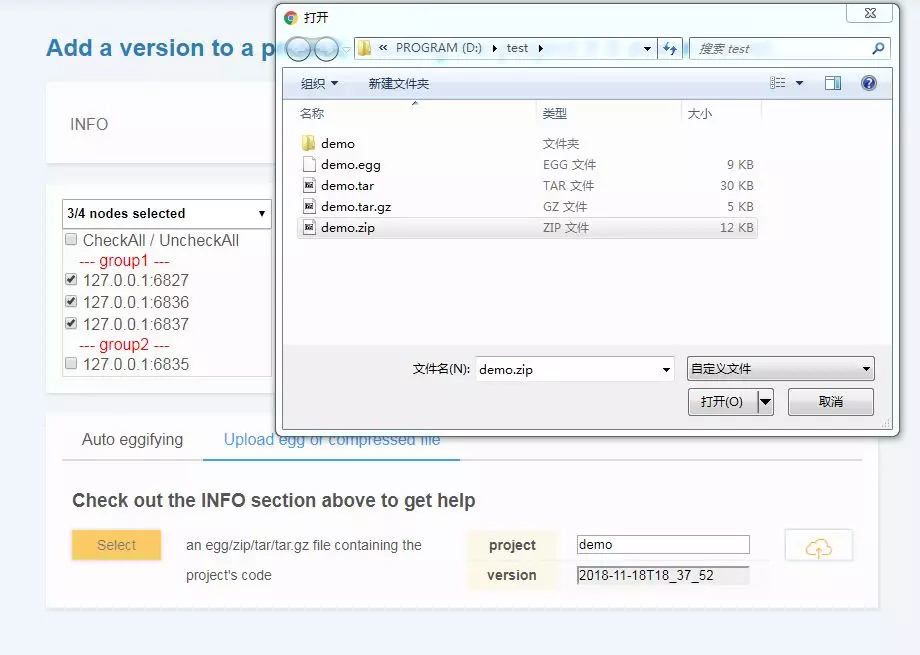

三.部署项目

- 通过配置

SCRAPY_PROJECTS_DIR指定 Scrapy 项目开发目录,ScrapydWeb 将自动列出该路径下的所有项目,默认选定最新编辑的项目,选择项目后即可自动打包和部署指定项目。 - 如果 ScrapydWeb 运行在远程服务器上,除了通过当前开发主机上传常规的 egg 文件,也可以将整个项目文件夹添加到 zip/tar/tar.gz 压缩文件后直接上传即可,无需手动打包为 egg 文件。

- 支持一键部署项目到 Scrapyd server 集群。

四.运行爬虫

通过下拉框直接选择 project,version 和 spider

支持传入 Scrapy settings 和 spider arguments

同样支持指定若干台 Scrapyd server 运行爬虫

五.定时爬虫任务

- 支持查看爬虫任务的参数信息,追溯历史记录

- 支持暂停,恢复,触发,停止,编辑和删除任务等操

六.日志可视化

默认情况下,ScrapydWeb 将在后台定时自动读取和分析 Scrapy log 文件并生成 Stats 页面

七.邮件通知

基于后台定时读取和分析 Scrapy log 文件,ScrapydWeb 将在满足特定触发器时发送通知邮件,邮件正文包含当前运行任务的统计信息。

1、添加邮箱帐号:

SMTP_SERVER = 'smtp.qq.com'

SMTP_PORT = 465

SMTP_OVER_SSL = True

SMTP_CONNECTION_TIMEOUT = 10 FROM_ADDR = 'username@qq.com'

EMAIL_PASSWORD = 'password'

TO_ADDRS = ['username@qq.com']

2、设置邮件工作时间和基本触发器,以下示例代表:每隔1小时或某一任务完成时,并且当前时间是工作日的9点,12点和17点,ScrapydWeb 将会发送通知邮件。

EMAIL_WORKING_DAYS = [1, 2, 3, 4, 5]

EMAIL_WORKING_HOURS = [9, 12, 17]

ON_JOB_RUNNING_INTERVAL = 3600

ON_JOB_FINISHED = True

3、除了基本触发器,ScrapydWeb 还提供了多种触发器用于处理不同类型的 log,包括 'CRITICAL', 'ERROR', 'WARNING', 'REDIRECT', 'RETRY' 和 'IGNORE'等。

LOG_CRITICAL_THRESHOLD = 3

LOG_CRITICAL_TRIGGER_STOP = True

LOG_CRITICAL_TRIGGER_FORCESTOP = False

#...

LOG_IGNORE_TRIGGER_FORCESTOP = False

以上示例代表:当发现3条或3条以上的 critical 级别的 log 时,ScrapydWeb 自动停止当前任务,如果当前时间在邮件工作时间内,则同时发送通知邮件。

scrapydweb的初步使用(管理分布式爬虫)的更多相关文章

- gerapy的初步使用(管理分布式爬虫)

一.简介与安装 Gerapy 是一款分布式爬虫管理框架,支持 Python 3,基于 Scrapy.Scrapyd.Scrapyd-Client.Scrapy-Redis.Scrapyd-API.Sc ...

- gerapy+scrapyd组合管理分布式爬虫

Scrapyd是一款用于管理scrapy爬虫的部署和运行的服务,提供了HTTP JSON形式的API来完成爬虫调度涉及的各项指令.Scrapyd是一款开源软件,代码托管于Github上. 点击此链接h ...

- 第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理

第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理 1.映射(mapping)介绍 映射:创建索引的时候,可以预先定义字 ...

- 四十三 Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理

1.映射(mapping)介绍 映射:创建索引的时候,可以预先定义字段的类型以及相关属性elasticsearch会根据json源数据的基础类型猜测你想要的字段映射,将输入的数据转换成可搜索的索引项, ...

- Python分布式爬虫原理

转载 permike 原文 Python分布式爬虫原理 首先,我们先来看看,如果是人正常的行为,是如何获取网页内容的. (1)打开浏览器,输入URL,打开源网页 (2)选取我们想要的内容,包括标题,作 ...

- 基于Python,scrapy,redis的分布式爬虫实现框架

原文 http://www.xgezhang.com/python_scrapy_redis_crawler.html 爬虫技术,无论是在学术领域,还是在工程领域,都扮演者非常重要的角色.相比于其他 ...

- 纯手工打造简单分布式爬虫(Python)

前言 这次分享的文章是我<Python爬虫开发与项目实战>基础篇 第七章的内容,关于如何手工打造简单分布式爬虫 (如果大家对这本书感兴趣的话,可以看一下 试读样章),下面是文章的具体内容. ...

- Scrapy+Scrapy-redis+Scrapyd+Gerapy 分布式爬虫框架整合

简介:给正在学习的小伙伴们分享一下自己的感悟,如有理解不正确的地方,望指出,感谢~ 首先介绍一下这个标题吧~ 1. Scrapy:是一个基于Twisted的异步IO框架,有了这个框架,我们就不需要等待 ...

- 跟繁琐的命令行说拜拜!Gerapy分布式爬虫管理框架来袭!

背景 用 Python 做过爬虫的小伙伴可能接触过 Scrapy,GitHub:https://github.com/scrapy/scrapy.Scrapy 的确是一个非常强大的爬虫框架,爬取效率高 ...

随机推荐

- 吴裕雄--天生自然 R语言开发学习:主成分分析和因子分析(续一)

#--------------------------------------------# # R in Action (2nd ed): Chapter 14 # # Principal comp ...

- fiddler 针对单个接口打断点

在命令行输入相关指令: 以慕课网为例: 请求前设置断点:bpu 实例: bpu https://www.imooc.com/index/getstarlist 请求 https://www.imooc ...

- 阿里云ECS 实例Centos7系统磁盘扩容

需求:一台阿里云的数据盘磁盘空间不足,需要扩容,我这里只有一个主分区,ext4文件系统. 因为磁盘扩容场景不同,阿里云的文档比较全面一些,所以先奉上阿里云的文档,下面开始我的操作步骤: 1.登录控制台 ...

- 15.uboot study 串口初始化

3. 串口初始化 4. 代码实现 关于串口 对于嵌入式设备的开发,刚开始好多设备都无法使用,由于无法获得程序的运行状态,调试程序需要花费好多时间和精力,因此串口对于嵌入式程序的调试的作用显而易见,当串 ...

- LeetCode#476 Number Complement - in Swift

Given a positive integer, output its complement number. The complement strategy is to flip the bits ...

- PHP创建缓存文件

文件操作类 <?php /** 文件操作类 */ class FileIO { /** * 读取目录 * @param string $dirPath dir名称 * @return array ...

- 在线选题系统完善篇(PHP)

第一篇: 选题在线提交系统(html+JS+PHP) 这是当时根据需求做的一个简单的版本,只能适用于这一个场景,而且题目等一系列数据都不能改.然后结束后,我又对重新写了一个有后台管理的选题系统.相对于 ...

- Java工厂模式解耦 —— 理解Spring IOC

Java工厂模式解耦 -- 理解Spring IOC 最近看到一个很好的思想来理解Spring IOC,故记录下来. 资源获取方式 主动式:(要什么资源都自己创建) 被动式:(资源的获取不是我们创建, ...

- NumPy——统计函数

引入模块import numpy as np 1.numpy.sum(a, axis=None)/a.sum(axis=None) 根据给定轴axis计算数组a相关元素之和,axis整数或元组,不指定 ...

- python下载神通板砖有声版

背景 前端时间在喜马拉雅上偶然听到牛大宝说的有声小说神通板砖,说的很是幽默,听的正起劲的时候开始收费了,于是我就在网上找了下看看有没有免费版,一搜果然有,但该网站上广告太多了,于是我就写了个小脚本可以 ...