新闻网大数据实时分析可视化系统项目——6、HBase分布式集群部署与设计

HBase是一个高可靠、高性能、面向列、可伸缩的分布式存储系统,利用Hbase技术可在廉价PC Server上搭建 大规模结构化存储集群。

HBase 是Google Bigtable 的开源实现,与Google Bigtable 利用GFS作为其文件存储系统类似, HBase 利用Hadoop HDFS 作为其文件存储系统;Google 运行MapReduce 来处理Bigtable中的海量数据, HBase 同样利用Hadoop MapReduce来处理HBase中的海量数据;Google Bigtable 利用Chubby作为协同服务, HBase 利用Zookeeper作为对应。

1.下载HBase并安装

1)下载Apache版本的HBase。

2)下载Cloudera版本的HBase。

3)这里选择下载cdh版本的hbase-0.98.6-cdh5.3.0.tar.gz,然后上传至bigdata-pro01.kfk.com节点/opt/softwares/目录下

4)解压hbase

tar -zxf hbase-0.98.6-cdh5.3.0.tar.gz -C /opt/modules/

2.分布式集群的相关配置

1)HBase架构体系

a.Zookeeper

Zookeeper Quorum中除了存储了-ROOT-表的地址和HMaster的地址,HRegionServer也会把自己以Ephemeral方式注册到Zookeeper中,使得HMaster可以随时感知到各个HRegionServer的健康状态。此外,Zookeeper也避免了HMaster的单点问题。

b.HBase Master

每台HRegion服务器都会和HMaster服务器通信,HMaster的主要任务就是要告诉每台HRegion服务器它要维护哪些HRegion。 当一台新的HRegion服务器登录到HMaster服务器时,HMaster会告诉它先等待分配数据。而当一台HRegion死机时,HMaster会把它负责的HRegion标记为未分配,然后再把它们分配到其他HRegion服务器中。

c.HRegionServer

HRegionServer主要负责响应用户I/O请求,向HDFS文件系统中读写数据,是HBase中最核心的模块。

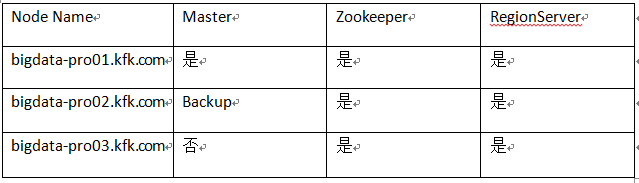

2)HBase集群规划

3)分布式集群相关配置

a.hbase-env.sh

#配置jdk

export JAVA_HOME=/opt/modules/jdk1.7.0_67

#使用独立的Zookeeper

export HBASE_MANAGES_ZK=false

b.hbase-site.xml

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://ns/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>bigdata-pro01.kfk.com,bigdata-pro02.kfk.com,

bigdata-pro03.kfk.com</value>

</property>

</configuration>

c.regionservers

bigdata-pro01.kfk.com

bigdata-pro02.kfk.com

bigdata-pro03.kfk.com

d.backup-masters

bigdata-pro02.kfk.com

4)将hbase配置分发到各个节点

scp -r hbase-0.98.6-cdh5.3.0 bigdata-pro02.kfk.com:/opt/modules/

scp -r hbase-0.98.6-cdh5.3.0 bigdata-pro03.kfk.com:/opt/modules/

3.启动HBase服务

1)各个节点启动Zookeeper

zkServer.sh start

2)主节点启动HDFS

bin/start-dfs.sh

3)启动HBase

bin/start-hbase.sh

4)查看HBase Web界面

bigdata-pro01.kfk.com:60010/

如果各个节点启动正常,那么HBase就搭建完毕。

4.通过shell测试数据库

1)选择主节点进入HBase目录,启动hbase-shell

cd hbase-0.98.6-cdh5.3.0

bin/hbase-shell

2)查看所有表命令

list

3)使用help帮助命令

help

4)创建表

create 'test','info'

5)添加数据

put 'test','0001','info:userName','laocao'

6)全表扫描数据

scan 'test'

7)查看表结构

describe 'test'

8)删除表

disable 'test'

drop 'test'

5.根据业务需求创建表结构

1)下载数据源文件

2)HBase上创建表

create 'weblogs','info'

新闻网大数据实时分析可视化系统项目——6、HBase分布式集群部署与设计的更多相关文章

- 新闻网大数据实时分析可视化系统项目——2、linux环境准备与设置

1.Linux系统常规设置 1)设置ip地址 使用界面修改ip比较方便,如果Linux没有安装操作界面,需要使用命令:vi /etc/sysconfig/network-scripts/ifcfg-e ...

- 新闻网大数据实时分析可视化系统项目——18、Spark SQL快速离线数据分析

1.Spark SQL概述 1)Spark SQL是Spark核心功能的一部分,是在2014年4月份Spark1.0版本时发布的. 2)Spark SQL可以直接运行SQL或者HiveQL语句 3)B ...

- 新闻网大数据实时分析可视化系统项目——13、Cloudera HUE大数据可视化分析

1.Hue 概述及版本下载 1)概述 Hue是一个开源的Apache Hadoop UI系统,最早是由Cloudera Desktop演化而来,由Cloudera贡献给开源社区,它是基于Python ...

- 新闻网大数据实时分析可视化系统项目——7、Kafka分布式集群部署

Kafka是由LinkedIn开发的一个分布式的消息系统,使用Scala编写,它以可水平扩展和高吞吐率而被广泛使用.目前越来越多的开源分布式处理系统如Cloudera.Apache Storm.Spa ...

- 新闻网大数据实时分析可视化系统项目——4、Zookeeper分布式集群部署

ZooKeeper 是一个针对大型分布式系统的可靠协调系统:它提供的功能包括:配置维护.名字服务.分布式同步.组服务等: 它的目标就是封装好复杂易出错的关键服务,将简单易用的接口和性能高效.功能稳定的 ...

- 新闻网大数据实时分析可视化系统项目——19、Spark Streaming实时数据分析

1.Spark Streaming功能介绍 1)定义 Spark Streaming is an extension of the core Spark API that enables scalab ...

- 新闻网大数据实时分析可视化系统项目——14、Spark2.X环境准备、编译部署及运行

1.Spark概述 Spark 是一个用来实现快速而通用的集群计算的平台. 在速度方面, Spark 扩展了广泛使用的 MapReduce 计算模型,而且高效地支持更多计算模式,包括交互式查询和流处理 ...

- 新闻网大数据实时分析可视化系统项目——12、Hive与HBase集成进行数据分析

(一)Hive 概述 (二)Hive在Hadoop生态圈中的位置 (三)Hive 架构设计 (四)Hive 的优点及应用场景 (五)Hive 的下载和安装部署 1.Hive 下载 Apache版本的H ...

- 新闻网大数据实时分析可视化系统项目——5、Hadoop2.X HA架构与部署

1.HDFS-HA架构原理介绍 hadoop2.x之后,Clouera提出了QJM/Qurom Journal Manager,这是一个基于Paxos算法实现的HDFS HA方案,它给出了一种较好的解 ...

随机推荐

- 大端(bigend)与小端(littleend)

大端:是指数据的低位保存在内存的高地址中,而数据的高位,保存在内存的低地址中: 小端:是指数据的高位保存在内存的高地址中,而数据的高 ...

- SQL按照某一列数据去重并显示整行信息

mysql按照某一字段去重,并显示其他字段信息.有时候会有一些这样的需求,就是按照sql中的某一列值去重,还要显示其他字段的信息.用distinct进行去重时不能显示整行的信息,对这种需求显然难以满足 ...

- ABC156E

题目链接 也是简单的组合数学问题,每个位置可以移动走,也可以移动来,那么我们就需要找最终的状态,也就是最终的0的个数 假设有m个0,就有n-m个非0空位,选择0的组合数为\(\textrm{C}_{n ...

- 绕过QQ群文件下载限速

绕过QQ群文件下载限速 引言 众所周知,用QQ客户端下载QQ群文件,速度往往被限为10KB/s.这里我们来讲讲如何绕过这一限制. 原始事件发生在2020年2月2日,值武汉疫情爆发,全国各省市纷纷下令推 ...

- python学习笔记:字符串格式化

% 格式化方法 "我的名字是 %s, 我的年龄是 %d" % (name, age) 常用格式:%[(name)][flags][width].[precision]typecod ...

- day46_Webservice学习笔记_02

一.回顾昨天所学 什么是webservice? 什么是远程调用技术?答:系统和系统之间的调用,从远程系统当中获取业务数据. Webservice是web服务,他是用http传输SOAP协议 ...

- PyQt5复杂控件(树控件、选项卡控件(滚动条控件、多文档控件、停靠控件)

1.树控件的基本使用方法QTreeWidget'''QTreeWidget树控件的使用方法添加图标,添加表格,添加复选框等'''from PyQt5.QtWidgets import *from Py ...

- Spring Boot 定时任务 Quartz 使用教程

Quartz是一个完全由java编写的开源作业调度框架,他使用非常简单.本章主要讲解 Quartz在Spring Boot 中的使用. 快速集成 Quartz 介绍 Quartz 几个主要技术点 Qu ...

- spring整合web项目

Web项目如何初始化SpringIOC容器 :思路:当服务启动时(tomcat),通过监听器将SpringIOC容器初始化一次(该监听器 spring-web.jar已经提供),web项目启动时 ,会 ...

- R - Fence Repair POJ - 3253

Farmer John wants to repair a small length of the fence around the pasture. He measures the fence an ...