<scrapy爬虫>爬取360妹子图存入mysql(mongoDB还没学会,学会后加上去)

1.创建scrapy项目

dos窗口输入:

scrapy startproject images360

cd images360

2.编写item.py文件(相当于编写模板,需要爬取的数据在这里定义)

import scrapy class Images360Item(scrapy.Item):

# define the fields for your item here like:

#图片ID

image_id = scrapy.Field()

#链接

url = scrapy.Field()

#标题

title = scrapy.Field()

#缩略图

thumb = scrapy.Field()

3.创建爬虫文件

dos窗口输入:

scrapy genspider myspider images.so.com

4.编写myspider.py文件(接收响应,处理数据)

# -*- coding: utf-8 -*-

from urllib.parse import urlencode

import scrapy

from images360.items import Images360Item

import json class MyspiderSpider(scrapy.Spider):

name = 'myspider'

allowed_domains = ['images.so.com']

urls = []

data = {'ch': 'beauty', 'listtype': 'new'}

base_url = 'https://image.so.com/zj?0'

for page in range(1,51):

data['sn'] = page * 30

params = urlencode(data)

url = base_url + params

urls.append(url)

print(urls)

start_urls = urls # ch: beauty

# sn: 120

# listtype: new

# temp: 1 def parse(self, response):

result = json.loads(response.text)

for each in result.get('list'):

item = Images360Item()

item['image_id'] = each.get('imageid')

item['url'] = each.get('qhimg_url')

item['title'] = each.get('group_title')

item['thumb'] = each.get('qhimg_thumb_url')

yield item

5.编写pipelines.py(存储数据)

import pymysql.cursors class Images360Pipeline(object):

def __init__(self):

self.connect = pymysql.connect(

host='localhost',

user='root',

password='',

database='quotes',

charset='utf8',

)

self.cursor = self.connect.cursor() def process_item(self, item, spider):

item = dict(item)

sql = 'insert into images360(image_id,url,title,thumb) values(%s,%s,%s,%s)'

self.cursor.execute(sql, (item['image_id'], item['url'], item['title'],item['thumb']))

self.connect.commit()

return item def close_spider(self, spider):

self.cursor.close()

self.connect.close()

6.编写settings.py(设置headers,pipelines等)

robox协议

# Obey robots.txt rules

ROBOTSTXT_OBEY = False

headers

DEFAULT_REQUEST_HEADERS = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

# 'Accept-Language': 'en',

}

pipelines

ITEM_PIPELINES = {

'quote.pipelines.Images360Pipeline': 300,

}

7.运行爬虫

dos窗口输入:

scrapy crawl myspider

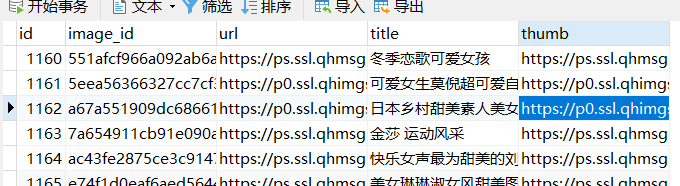

运行结果

<scrapy爬虫>爬取360妹子图存入mysql(mongoDB还没学会,学会后加上去)的更多相关文章

- 写一个python 爬虫爬取百度电影并存入mysql中

目标是利用python爬取百度搜索的电影 在类型 地区 年代各个标签下 电影的名字 评分 和图片连接 以及 电影连接 首先我们先在mysql中建表 create table liubo4( id in ...

- Scrapy框架学习(四)爬取360摄影美图

我们要爬取的网站为http://image.so.com/z?ch=photography,打开开发者工具,页面往下拉,观察到出现了如图所示Ajax请求, 其中list就是图片的详细信息,接着观察到每 ...

- 使用scrapy爬虫,爬取17k小说网的案例-方法一

无意间看到17小说网里面有一些小说小故事,于是决定用爬虫爬取下来自己看着玩,下图这个页面就是要爬取的来源. a 这个页面一共有125个标题,每个标题里面对应一个内容,如下图所示 下面直接看最核心spi ...

- <scrapy爬虫>爬取猫眼电影top100详细信息

1.创建scrapy项目 dos窗口输入: scrapy startproject maoyan cd maoyan 2.编写item.py文件(相当于编写模板,需要爬取的数据在这里定义) # -*- ...

- <scrapy爬虫>爬取quotes.toscrape.com

1.创建scrapy项目 dos窗口输入: scrapy startproject quote cd quote 2.编写item.py文件(相当于编写模板,需要爬取的数据在这里定义) import ...

- scrapy爬虫爬取小姐姐图片(不羞涩)

这个爬虫主要学习scrapy的item Pipeline 是时候搬出这张图了: 当我们要使用item Pipeline的时候,要现在settings里面取消这几行的注释 我们可以自定义Item Pip ...

- 使用scrapy爬虫,爬取今日头条搜索吉林疫苗新闻(scrapy+selenium+PhantomJS)

这一阵子吉林疫苗案,备受大家关注,索性使用爬虫来爬取今日头条搜索吉林疫苗的新闻 依然使用三件套(scrapy+selenium+PhantomJS)来爬取新闻 以下是搜索页面,得到吉林疫苗的搜索信息, ...

- <scrapy爬虫>爬取校花信息及图片

1.创建scrapy项目 dos窗口输入: scrapy startproject xiaohuar cd xiaohuar 2.编写item.py文件(相当于编写模板,需要爬取的数据在这里定义) # ...

- <scrapy爬虫>爬取腾讯社招信息

1.创建scrapy项目 dos窗口输入: scrapy startproject tencent cd tencent 2.编写item.py文件(相当于编写模板,需要爬取的数据在这里定义) # - ...

随机推荐

- 利用Delphi全面控制Windows任务栏

使用Windows95/NT/98操作系统的用户知道:Windows正常启动后,在电脑屏幕下方出现一块 任务栏.从系统功能角度而言,整个任务栏包括几个不同的子区域,从左至右依次是:开始 按钮.应用程序 ...

- Delphi实现屏幕截图、窗口截图、指定区域截图

Use Jpeg procedure TForm1.snapscreen(a,b,c,d:Integer); var bmpscreen:Tbitmap; jpegscreen:Tjpegimage; ...

- thinkphp 原生分页

paginate() 是有三个参数: 第一个参数是 $listRows [int],也就是当前的页数 第二个参数是 $simple [boolean], 是否简洁模式或者总记录数 第三个参数是 $co ...

- 【6折抢】戴尔i7新品Latitude高性能商用本

致敬拼搏成长中的企业 戴尔5月有钜惠! 买1赠1送同款,单台价格2500元 这波来自戴尔官网的致敬很走心 满足初级办公和高性能运算多重需求 限时折扣火热开抢! 新品 latitude 6折抢! 戴尔 ...

- jpa简单规则(转https://www.cnblogs.com/rulian/p/6434631.html)

一.常用规则速查 1 And 并且2 Or 或3 Is,Equals 等于4 Between 两者之间5 LessThan 小于6 LessThanEqual 小于等于7 Gre ...

- sort()和优先队列的总结

一.关于sort函数 sort()排序函数默认是从小到大, a={5,3,2,1,6 }; sort(a,a+n); //输出是1 2 3 5 6 这里如果要从到小排序,则有两种方式可以满足 (1) ...

- CSS Sprites(CSS图像拼合技术)教程、工具集合

本集合是有一位国外设计师收集整合,并由 oncoding翻译成中文的,感谢他们的辛苦贡献.CSS Sprites技术在国外并不是什么新技术,只不过近两年(尤其08年开始)中国开始流行这个词,大家也开始 ...

- D3.js坐标轴的绘制方法、添加坐标轴的刻度和各比例尺的坐标轴(V3版本)

坐标轴(Axis) 坐标轴(Axis)在很多图表中都可见到,例如柱形图.折线图.散点图等.坐标轴由一组线段和文字组成,坐标轴上的点由一个坐标值确定.但是,如果使用SVG的直线和文字一笔一画的绘制坐 ...

- mysql sql时间戳格式化语句

FROM_UNIXTIME(c.lastUpdateTime/1000,'%Y-%c-%d %h:%i:%s' ) as updatetime; select c.roleid, r.username ...

- 【笔记篇】斜率优化dp(四) ZJOI2007仓库建设

传送门戳这里>>> \(n\leq1e6\), 显然还是\(O(n)\)的做法. 这个题有个条件是只能运往编号更大的工厂的仓库, 这也是写出朴素dp的方程的条件. 我们令\(f[i] ...