【GUI开发】用python爬YouTube博主信息,并开发成exe软件!

一、背景介绍

你好,我是@马哥python说,一名10年程序猿。

最近我用python开发了一个GUI桌面软件,目的是爬取相关YouTube博主的各种信息,字段包括:

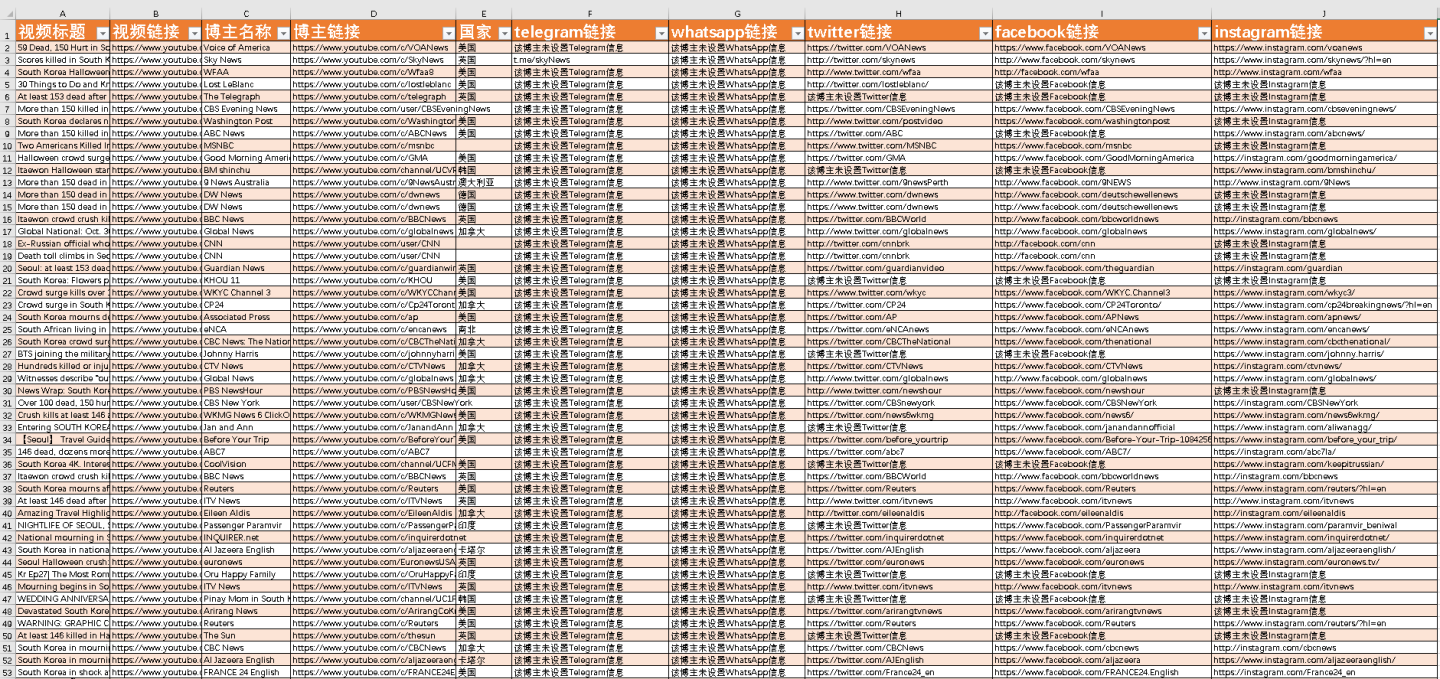

视频标题、视频链接、博主名称、博主链接、国家、telegram链接、whatsapp链接、twitter链接、facebook链接、instagram链接。

以近期某热门事件为例。

演示视频:

【爬虫演示】用python爬YouTube博主信息,并开发成GUI桌面软件!

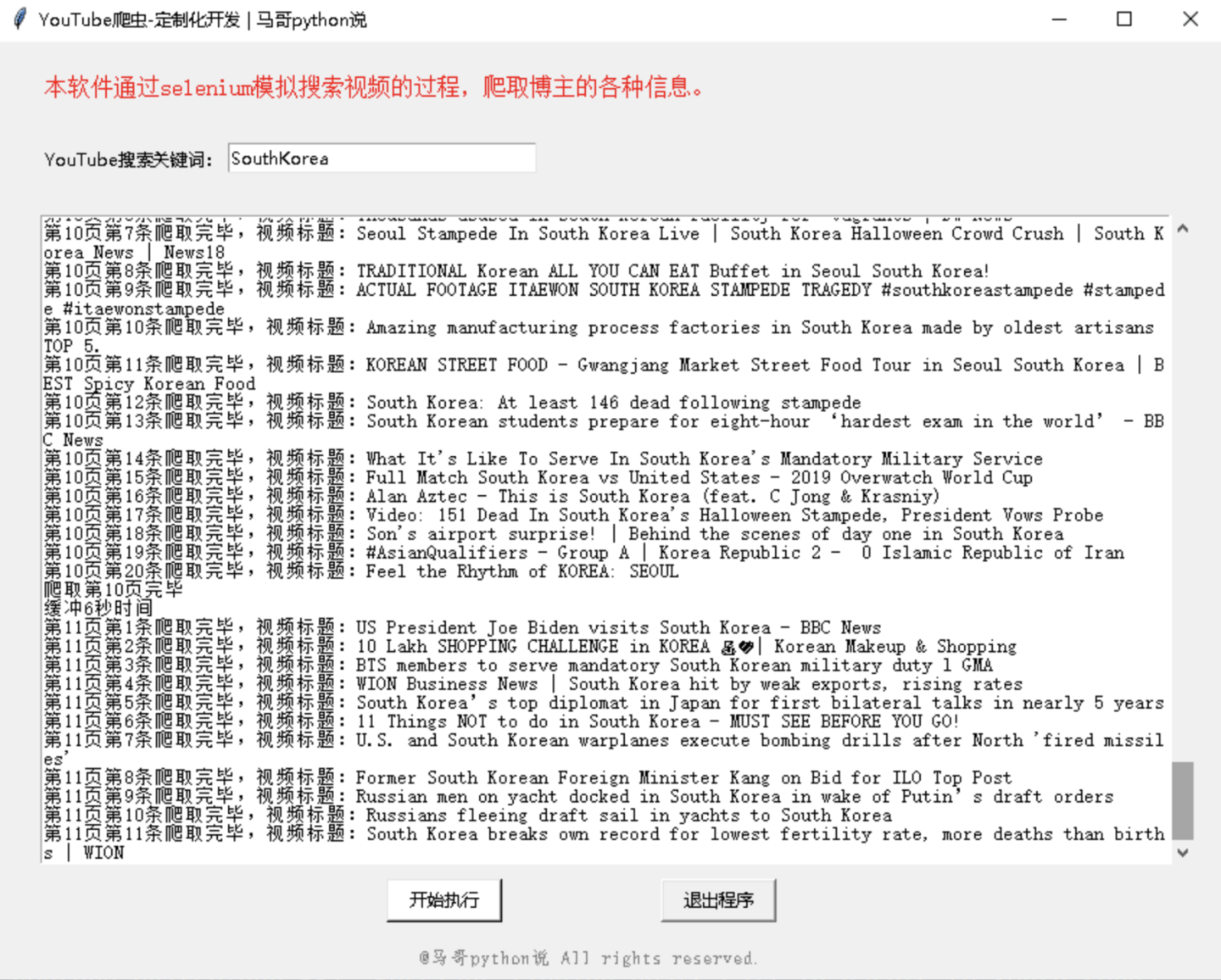

运行截图:

爬取数据截图:

实现思路:

通过按指定关键词搜索视频,通过视频进入博主的主页简介,爬取博主的各种联系信息。

并把源码封装成exe文件,方便没有python环境,或者不懂技术的人使用它。

二、代码讲解

2.1 爬虫

本爬虫是通过selenium模拟手工搜索的过程,所以需要提前安装好chrome浏览器和chromedriver驱动。

安装chrome浏览器和chromedriver驱动的过程,请自行解决,不再赘述。

把chromedriver放到exe文件的旁边(同级目录下)即可。

展示部分核心代码:

初始化csv文件:

def init(self):

with open(f'{self.query}.csv', 'a', newline='', encoding='utf_8_sig') as f:

writer = csv.writer(f)

writer.writerow(['视频标题', '视频链接', '博主名称', '博主链接', '国家', 'telegram链接', 'whatsapp链接', 'twitter链接', 'facebook链接', 'instagram链接'])

爬博主信息:

# 先解析出所有链接

contact_url_els = self.browser.find_elements(By.XPATH, '//*[@id="link-list-container"]/a')

for j in contact_url_els:

url = j.get_attribute('href')

if "t.me" in url: # 电报链接

de_url = unquote(url)

de_url_dict = parse_qs(urlparse(de_url).query)

url = de_url_dict.get("q")[0]

telegram_url = url

if "wa.link" in url or "api.whatsapp.com" in url: # whatsapp链接

de_url = unquote(url)

de_url_dict = parse_qs(urlparse(de_url).query)

url = de_url_dict.get("q")[0]

whatsapp_url = url

if "twitter.com" in url: # twitter链接

de_url = unquote(url)

de_url_dict = parse_qs(urlparse(de_url).query)

url = de_url_dict.get("q")[0]

twitter_url = url

if "facebook.com" in url: # facebook链接

de_url = unquote(url)

de_url_dict = parse_qs(urlparse(de_url).query)

url = de_url_dict.get("q")[0]

facebook_url = url

if "instagram.com" in url: # instagram链接

de_url = unquote(url)

de_url_dict = parse_qs(urlparse(de_url).query)

url = de_url_dict.get("q")[0]

instagram_url = url

2.2 tkinter界面

界面部分代码:

# 创建主窗口

root = tk.Tk()

root.title('YouTube爬虫-定制化开发 | 马哥python说')

# 设置窗口大小

root.minsize(width=850, height=650)

show_list_Frame = tk.Frame(width=800, height=450) # 创建<消息列表分区>

show_list_Frame.pack_propagate(0)

show_list_Frame.place(x=30, y=120, anchor='nw') # 摆放位置

# 滚动条

scroll = tk.Scrollbar(show_list_Frame)

# 放到Y轴竖直方向

scroll.pack(side=tk.RIGHT, fill=tk.Y)

2.3 存日志

软件运行过程中,会在同级目录下生成logs文件夹,文件夹内会出现log文件,记录下软件在整个运行过程中的日志,方便长时间运行、无人值守,出现问题后的debug。

部分代码:

class Log_week():

def get_logger(self):

self.logger = logging.getLogger(__name__)

# 日志格式

formatter = '[%(asctime)s-%(filename)s][%(funcName)s-%(lineno)d]--%(message)s'

# 日志级别

self.logger.setLevel(logging.DEBUG)

# 控制台日志

sh = logging.StreamHandler()

log_formatter = logging.Formatter(formatter, datefmt='%Y-%m-%d %H:%M:%S')

# info日志文件名

info_file_name = time.strftime("%Y-%m-%d") + '.log'

# 将其保存到特定目录,ap方法就是寻找项目根目录,该方法博主前期已经写好。

case_dir = r'./logs/'

info_handler = TimedRotatingFileHandler(filename=case_dir + info_file_name,

when='MIDNIGHT',

interval=1,

backupCount=7,

encoding='utf-8')

self.logger.addHandler(sh)

sh.setFormatter(log_formatter)

self.logger.addHandler(info_handler)

info_handler.setFormatter(log_formatter)

return self.logger

三、说明

附完整源码:点击此处完整源码

我是 @马哥python说,持续分享python源码干货!

推荐阅读: 【爬虫+情感判定+Top10高频词+词云图】"乌克兰"油管热评python舆情分析

【GUI开发】用python爬YouTube博主信息,并开发成exe软件!的更多相关文章

- 正则爬取京东商品信息并打包成.exe可执行程序。

本文爬取内容,输入要搜索的关键字可自动爬取京东网站上相关商品的店铺名称,商品名称,价格,爬取100页(共100页) 代码如下: import requests import re # 请求头 head ...

- 正则爬取京东商品信息并打包成.exe可执行程序

本文爬取内容,输入要搜索的关键字可自动爬取京东网站上相关商品的店铺名称,商品名称,价格,爬取100页(共100页) 代码如下: ? 1 2 3 4 5 6 7 8 9 10 11 12 13 14 1 ...

- python爬取博客圆首页文章链接+标题

新人一枚,初来乍到,请多关照 来到博客园,不知道写点啥,那就去瞄一瞄大家都在干什么好了. 使用python 爬取博客园首页文章链接和标题. 首先当然是环境了,爬虫在window10系统下,python ...

- Python抖音视频去水印,并打包成exe可执行文件

前言 抖音里面的视频保存之后,会发现全都带有水印,所以如何解决视频去除水印就很有必要,所以教程来了,本次教程不仅会教大家如何去除视频里的水印,并且教大家将程序制作成exe可执行文件,可以发给你的好友使 ...

- 【GUI开发案例】用python爬百度搜索结果,并开发成exe桌面软件!

一.背景介绍 你好,我是 @马哥python说 ,一名10年程序猿. 1.1 老版本 之前我开发过一个百度搜索的python爬虫代码,具体如下: [python爬虫案例]用python爬取百度的搜索结 ...

- python:爬取博主的所有文章的链接、标题和内容

以爬取我自己的博客为例:https://www.cnblogs.com/Mr-choa/ 1.获取所有的文章的链接: 博客文章总共占两页,比如打开第一页:https://www.cnblogs.com ...

- 爬取博主所有文章并保存到本地(.txt版)--python3.6

闲话: 一位前辈告诉我大学期间要好好维护自己的博客,在博客园发布很好,但是自己最好也保留一个备份. 正好最近在学习python,刚刚从py2转到py3,还有点不是很习惯,正想着多练习,于是萌生了这个想 ...

- 爬取博主的所有文章并保存为PDF文件

继续改进上一个项目,上次我们爬取了所有文章,但是保存为TXT文件,查看不方便,而且还无法保存文章中的代码和图片. 所以这次保存为PDF文件,方便查看. 需要的工具: 1.wkhtmltopdf安装包, ...

- python爬区csdn文章信息(原始稿)

使用python对csdn的博主文章进行爬取,期间又遇到了新的问题和旧的已经遇到过的问题.首先做一个笔记,免得以后遇到同样的问题时还得浪费时间和经历. 刚开始目的没那么明确,主要在于熟悉相关的规则及流 ...

- Python 爬取美团酒店信息

事由:近期和朋友聊天,聊到黄山酒店事情,需要了解一下黄山的酒店情况,然后就想着用python 爬一些数据出来,做个参考 主要思路:通过查找,基本思路清晰,目标明确,仅仅爬取美团莫一地区的酒店信息,不过 ...

随机推荐

- ArrayList扩容代码分析

ArrayList扩容机制是在面试中频繁出现的问题,平时了解的比较含糊,特此记录! 注意:每次发生扩容,其容量扩充为原来的1.5倍左右 add方法 public boolean add(E e) { ...

- Android按钮_单选框_多选框_文字框

1 <?xml version="1.0" encoding="utf-8"?> 2 <LinearLayout xmlns:android= ...

- 1.NCC算法实现及其优化[基础实现篇]

NCC算法实现及其优化 本文将集中探讨一种实现相对简单,效果较好的模板匹配算法(NCC) \[R(x,y)= \frac{ \sum_{x',y'} (T'(x',y') \cdot I'(x+x', ...

- 深入浅出 C 语言:学变量、掌控流程、玩指针,全方位掌握 C 编程技能

C 语言简介 C 语言介绍 C 语言的特性 C 语言相对于其他语言的优势 C 程序的编译 C 中的 Hello World 程序 参考文章: C 语言入门:如何编写 Hello World C 语言函 ...

- openGauss数据库的安装与使用

VMware+CentOS7.6+OpenGauss2.0.1 极简版安装 环境准备 Arch:x86-64 OS:Win11 VMware:16.1.2 安装 CentOS 7.6 CentOS 镜 ...

- 双端队列的基本实现【数据结构与算法—TypeScript 实现】

笔记整理自 coderwhy 『TypeScript 高阶数据结构与算法』课程 特性 本质:允许队列在两端进行 入队 和 出队 操作 设计 实现方式:基于 数组 实现 属性: data:存放队列元素 ...

- Prometheus之自定义标签

前言: 我们一般通过grafana导入Dashboard模板用来展示数据,但是有时候需要自己定义展示项目,这时需要自己在Prometheus重新自定义标签,并在grafana进行应用. 1.Prome ...

- mysql 必知必会整理—视图[十二]

前言 简单整理一下视图. 正文 视图: 需要MySQL 5 MySQL 5添加了对视图的支持.因此,本章内容适用于MySQL 5及以后的版本. 视图是虚拟的表.与包含数据的表不一样,视图只包含使用时动 ...

- webpack 打包jquery

前言 记一次配置webpack jqeury中的案例. 正文 选取自己需要安装的jquery版本号 dependencies:{ //此处的jquery版本根据npm后的版本来看,会有安装版本的提示 ...

- Spark3.0 Standalone模式部署

之前介绍过Spark 1.6版本的部署,现在最新版本的spark为3.0.1并且已经完全兼容hadoop 3.x,同样仍然支持RDD与DataFrame两套API,这篇文章就主要介绍一下基于Hadoo ...