吴裕雄--天生自然PYTHON爬虫:使用BeautifulSoup解析中国旅游网页数据

import requests

from bs4 import BeautifulSoup url = "http://www.cntour.cn/"

strhtml = requests.get(url)

soup = BeautifulSoup(strhtml.text,"lxml")

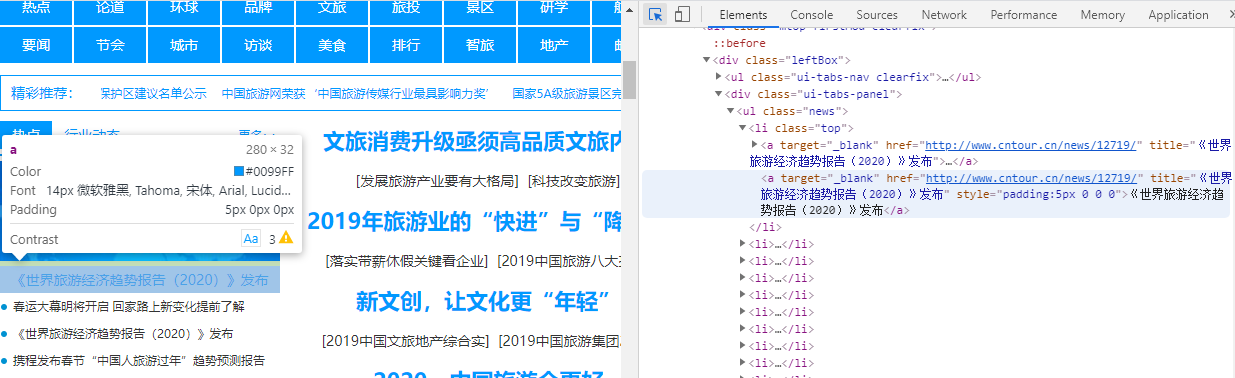

#下面的参数由网站开发者模式中Copy->copy selector复制而来

data = soup.select("#main > div > div.mtop.firstMod.clearfix > div.centerBox > ul.newsList > li:nth-child(1) > a")

print(data)

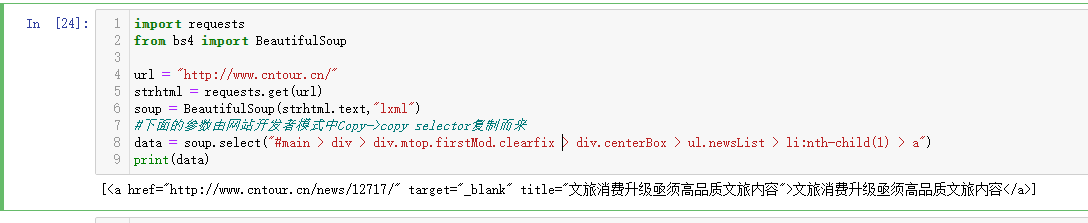

import requests

from bs4 import BeautifulSoup url = "http://www.cntour.cn/"

strhtml = requests.get(url)

soup = BeautifulSoup(strhtml.text,"lxml")

#下面的参数由网站开发者模式中Copy->copy selector复制而来,获取该网站所有超链接内容,删掉::nth-child(1),如下:

data = soup.select("#main > div > div.mtop.firstMod.clearfix > div.centerBox > ul.newsList > li > a")

print(data)

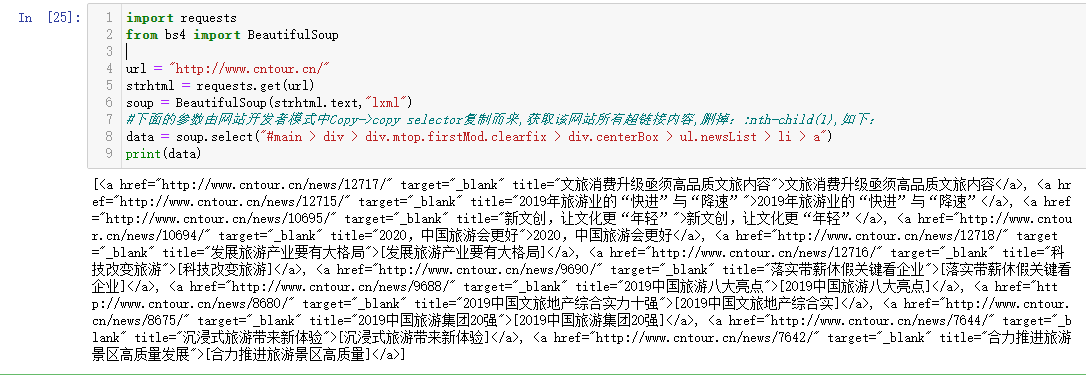

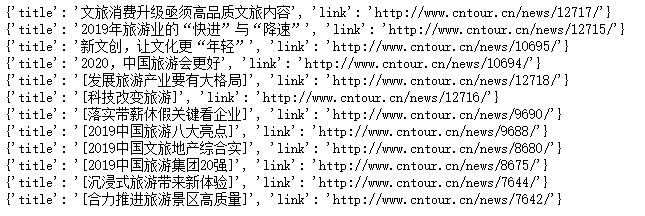

#清洗和组织爬取到的数据

import requests

from bs4 import BeautifulSoup url = "http://www.cntour.cn/"

strhtml = requests.get(url)

soup = BeautifulSoup(strhtml.text,"lxml")

#下面的参数由网站开发者模式中Copy->copy selector复制而来,获取该网站所有超链接内容,删掉::nth-child(1),如下:

data = soup.select("#main > div > div.mtop.firstMod.clearfix > div.centerBox > ul.newsList > li > a")

for item in data:

result={

"title":item.get_text(),

"link":item.get("href")

}

print(result)

#清洗和组织爬取到的数据,获取每个链接后面的ID

import re

import requests

from bs4 import BeautifulSoup url = "http://www.cntour.cn/"

strhtml = requests.get(url)

soup = BeautifulSoup(strhtml.text,"lxml")

#下面的参数由网站开发者模式中Copy->copy selector复制而来,获取该网站所有超链接内容,删掉::nth-child(1),如下:

data = soup.select("#main > div > div.mtop.firstMod.clearfix > div.centerBox > ul.newsList > li > a")

for item in data:

result={

"title":item.get_text(),

"link":item.get("href"),

"ID":re.findall("\d+",item.get("href"))

}

print(result)

吴裕雄--天生自然PYTHON爬虫:使用BeautifulSoup解析中国旅游网页数据的更多相关文章

- 吴裕雄--天生自然PYTHON爬虫:使用Scrapy抓取股票行情

Scrapy框架它能够帮助提升爬虫的效率,从而更好地实现爬虫.Scrapy是一个为了抓取网页数据.提取结构性数据而编写的应用框架,该框架是封装的,包含request异步调度和处理.下载器(多线程的Do ...

- 吴裕雄--天生自然PYTHON爬虫:使用Selenium爬取大型电商网站数据

用python爬取动态网页时,普通的requests,urllib2无法实现.例如有些网站点击下一页时,会加载新的内容,但是网页的URL却没有改变(没有传入页码相关的参数),requests.urll ...

- 吴裕雄--天生自然PYTHON爬虫:爬取某一大型电商网站的商品数据(效率优化以及代码容错处理)

这篇博文主要是对我的这篇https://www.cnblogs.com/tszr/p/12198054.html爬虫效率的优化,目的是为了提高爬虫效率. 可以根据出发地同时调用多个CPU,每个CPU运 ...

- 吴裕雄--天生自然PYTHON爬虫:爬虫攻防战

我们在开发者模式下不仅可以找到URL.Form Data,还可以在Request headers 中构造浏览器的请求头,封装自己.服务器识别浏览器访问的方法就是判断keywor是否为Request h ...

- 吴裕雄--天生自然PYTHON爬虫:安装配置MongoDBy和爬取天气数据并清洗保存到MongoDB中

1.下载MongoDB 官网下载:https://www.mongodb.com/download-center#community 上面这张图选择第二个按钮 上面这张图直接Next 把bin路径添加 ...

- 吴裕雄--天生自然PYTHON爬虫:用API爬出天气预报信息

天气预报网址:https://id.heweather.com/,这个网站是需要注册获取一个个人认证后台密钥key的,并且每个人都有访问次数的限制,这个key就是访问API的钥匙. 这个key现在是要 ...

- 吴裕雄--天生自然python爬虫:使用requests模块的get和post方式抓取中国旅游网站和有道翻译网站翻译内容数据

import requests url = 'http://www.cntour.cn/' strhtml = requests.get(url) print(strhtml.text) URL='h ...

- 吴裕雄--天生自然python学习笔记:pandas模块删除 DataFrame 数据

Pandas 通过 drop 函数删除 DataFrarne 数据,语法为: 例如,删除陈聪明(行标题)的成绩: import pandas as pd datas = [[65,92,78,83,7 ...

- 吴裕雄--天生自然python学习笔记:抓取网络公开数据

当前,有许多政府或企事业单位会在网上为公众提供相关的公开数据.以 http://api.help.bj.cn/api/均 .cn/api /网站为例,打开这个链接,大家可以看到多种可供调用的数据 . ...

随机推荐

- C# 动态类型 以及 脚本调用(scriptRunTime)

在使用中让我感觉 好像 JavaScript中的 动态类型囧 先看动态类型 class Program { static void Main(string[] args) { var streamRe ...

- Plastic Sprayers Manufacturer - Ingenious Design Of Spray Plastic Bottle

Plastic bottles are now an indispensable container in life. Plastic bottles will appear in all aspec ...

- 小程序云函数调用webservice接口

https://www.jianshu.com/p/2692e56251ac 小程序最近新出来了云开发能力,主要依赖了node.js(运行在服务器上的js),可以让我们在没有服务器的情况下,使用云开发 ...

- Android Studio 使用入门及问题汇总

声明:转载自http://blog.csdn.net/wei_chong_chong/article/details/56280383 之前一直用eclipse+adt做Android开发.曾经尝试使 ...

- dpkg 命令

dpkg 是Debian Package的简写,是为Debian 专门开发的套件管理系统,方便软件的安装.更新及移除.所有源自Debian的Linux发行版都使用dpkg,例如Ubuntu.Knopp ...

- slice 、 substr 、replace

slice( 参数1 [,参数2] ) (注意不要让[参数1]下标越过[参数2]下标,否则会得到空字符串,且[参数2]是不包含在截取范围内的) 参数1:截取字符的[起始下标]. 值为正 ...

- php 高级 多台web服务器共享session的方法

解决多台web服务器共享session的问题,至少有以下三种方法: 一.将本该保存在web服务器磁盘上的session数据保存到cookie中 即用cookie会话机制替代session会话机制, ...

- scrapy 中 shell 出现 403 Forbiidden 解决方案

版权声明本文来自:https://blog.csdn.net/qq_37462361/article/details/87860025 进入正题: 出现 403,表示网站拒绝提供服务 (因为很多网站都 ...

- UIAutomation 测试winForm

static void Main(string[] args) { Console.WriteLine("\n开始窗口程序自动化测试\n"); //启动被测试程序 string p ...

- 关于热部署Devtools出现同一个类型进行类型转换失败的问题

背景: 最近在和学长们做一个小系统,在进行任务调度的设置的时候会出现类型转换失败的错误,原本是同一个类型的,不应该出现类型转换失败的问题,起初以为是序列化的问题,回来发现并不是这个原因, 报错截图: ...